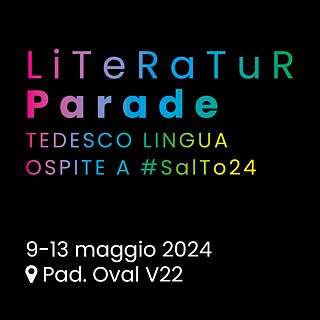

Literatur Parade. Tedesco Lingua Ospite a #SalTo24

Salone internazionale del Libro di Torino 2024

25 autrici e autori e numerosi eventi: la molteplicità e la ricchezza della letteratura in lingua tedesca al Salone Internazionale del libro di Torino.

Salone internazionale del Libro di Torino 2024

25 autrici e autori e numerosi eventi: la molteplicità e la ricchezza della letteratura in lingua tedesca al Salone Internazionale del libro di Torino.

La nostra esperienza al servizio del vostro successo

Il Goethe-Institut promuove lo studio del tedesco in tutto il mondo organizzando corsi di lingua ed esami di certificazione in ben 90 Paesi.

4 sedi in Italia

Promuoviamo la conoscenza della lingua tedesca all'estero e la collaborazione culturale internazionale. Grazie a più di 150 sedi nel mondo, veicoliamo informazioni sulla vita culturale in Germania e sulla lingua tedesca, intrattenendo contatti e collaborazioni con biblioteche ed enti culturali.

Cooperazione culturale