Mākslīgais intelekts pret naidu internetā

Moderna tehnika ar daudzām jautājuma zīmēm

Piecu līdz desmit gadu laikā mākslīgais intelekts būtu spējīgs atpazīt naida runu visās tās niansēs un automātiski to izdzēst – tā ASV Kongresa priekšā, sniedzot liecību, apgalvojis Marks Zakerbergs. Taču izpētes projekti jau šodien parāda šīs tehnoloģijas iespējas – kā arī to, par kādiem punktiem jau drīz jādiskutē.

“Jauna mākslīgā intelekta forma atrod 90 procentus no visām interneta ķengām,” 2016. gadā virsrakstā apgalvoja amerikāņu žurnāls Fortune. Ar to domāts bija Yahoo izstrādāts algoritms, kas tika trenēts uz vienu miljonu portāla komentāru. Programma konkurentus pārspējot ar savu precizitāti. Pētnieki toreiz gribēja aptvert plašāku kontekstu ne kā tikai lietotāju ierakstu atslēgas vārdu analīze, un tādēļ algoritmam pievienoja komentāru sadaļas no Yahoo News un Yahoo Finance. Naidīgo komentāru problēma kopš tā laika nav atrisināta. 2018. gada aprīlī Marks Zakerbergs, sniedzot liecību ASV Kongresa priekšā, minēja, ka desmit gadu laikā mākslīgais intelekts Facebook būs spējīgs atpazīt naida runu arī tās valodiskajās niansēs un automātiski izdzēst.

Taču cik gudra šī tehnoloģija ir jau šodien? Kādas problēmas rodas, to lietojot? Un kādi ir tās vājie punkti?

Zakerberga izteikums pārsteidza mediju valodnieci Silviju Jaki no Hildeshaimas Universitātes un viņas pētniecības kolēģi, valodas tehnologu Tomu de Smitu. “Mēs abi bijām izbrīnīti, jo tieši anglofonajās valstīs pētnieki jau ir tikuši ļoti tālu,” pauž Jaki. Tas noteikti vairs neprasīs piecus līdz desmit gadus, jo modernās mašīnas to spēj jau šodien. “Zakerbergs izklausījās ne visai labi informēts, taču, iespējams, viņa redzējums arī atšķiras un viņš vēlas gandrīz simtprocentīgu precizitāti.”

Kur beidzas vārda brīvība?

Kopā ar Antverpenes Universitātes zinātniekiem Jaki izveidoja Twitter naida runas detektoru. Šī automatizētā programma reāllaikā atrod musinošus vārdus un to kombinācijas vācu Twitter ierakstos un iesaista arī tādus elementus kā attēlus un emocijzīmes. Līdzatbildīgā mediju valodniece saka, ka algoritms tagad esot sasniedzis 84 procentu precizitāti. Taču Jaki neuzskata, ka tā tuvākajā laikā kļūs par perfektu meklētājmašīnu. “Pēc tās vienmēr būs vajadzīga cilvēka korektūra.”“Mašīnas lasa rindiņas, cilvēki lasa starp rindiņām,” saka Aļoša Burharts, Vācijas Mākslīgā intelekta pētniecības centra Valodas tehnoloģijas laboratorijas pētnieks, un norāda uz valodas polisēmiju. Vienkāršu valodas pazīmju atpazīšanai noderot mašīnmācīšanās un algoritmi. Šādi tie līdzinās filtram surogātpasta mapē. “Tomēr tehnoloģijas robežas ir sasniegtas tur, kur sākas mājieni, ironija un kultūras konteksts. Niansēti izteikumi, kuru doma, tā sakot, jānolasa starp rindiņām, un kas saprotami katram cilvēkam, algoritmiem ir teju neatpazīstami.” Tādēļ Zakerbergs ar savu norādi par mākslīgo intelektu izvairoties no redakcionālas atbildības, uzskata Burharts, un uzsver: “Naida runas atpazīšanas jomā jāstrādā cilvēkiem – ekspertiem.”

Diskusijas galvenais jautājums ir – kāda ir cilvēku attieksme pret mākslīgo intelektu cīņā pret naidīgiem komentāriem? “Bieži minēts atslēgvārds ir cenzūra,” saka Silvija Jaki. “Vieni ir sajūsmā par šādām iespējām, otri apgalvo, ka tas ir vārda brīvības pārkāpums.” Turklāt noteicošais būs tas, kā atsevišķās organizācijas un iestādes definēs jēdzienu “naida runa”. “Zakerberga liecība ASV Kongresa sēdē atdūrās pret klupšanas akmeni, un viņš runāja tik vien kā par vardarbīgiem uzsaukumiem,” saka Jaki. To, ka Facebook nekonsekventi īsteno savus standartus, parāda divi gadījumi, kuros Facebook uzņēmums ASV ir veicinājis dezinformācijas un slepkavošanas naida dēļ propagandas izplatību. Runa ir par rohindžu vajāšanu Mjanmā un pilsoņu karu Šrilankā. Buzzfeed pētījums atklāj, ka, neskatoties uz neskaitāmiem politiķu un pētnieku brīdinājumiem, Facebook vairāku gadu laikā tikpat kā nav reaģējis.

Vienota uztvere nepastāv arī institucionālā līmenī. “ES nav likumīgas definīcijas, kas konkrēti jāsaprot ar “naida runu”.” Jaki uzsver, ka pie tās bez šaubām pieder neslavas celšana un citi kā noziedzīgi definēti gadījumi. “Taču kad brīva uzskatu paušana tāda vairs nav?” Jaki piemērs – pelēkajā zonā atrodas komentāri, kuros migranti tiek attēloti kā noziedznieki. Šie komentāri tiek “piesegti” ar vārda brīvību. “Tomēr šo komentāru biežums padara tos par naida runu, jo mērķtiecīgas to nozīmes vājināšanas rezultātā tie kļūst par politisko propagandu.”

Vācijas Mākslīgā intelekta pētniecības centra pētnieks Burharts izskaidro mehānismu: “Ir divi veidi, kā mašīnas padarīt gudrākas. Pirmkārt, ar algoritmu, otrkārt, var ļaut tām mācīties ar datu ieraksta palīdzību.” Jo apjomīgāka un labāka informācija ir iekļauta mašīnā, jo tā kļūst precīzāka. Tomēr viņš piebilst: “Tas, kas labi nepadodas cilvēkam, vēl jo mazāk būs pa spēkam mašīnai.” Tas ir, ja cilvēki nespēj vienoties par to, kādi izteikumi iekļaujas vārda brīvības robežās un kādi ne, būs grūti to iemācīt mašīnai, kura šo spriedumu tad pārņems.

Problēma ar sarkasmu

Digitālais eksperts Saša Lobo Spiegel Online slejā ir rakstījis, ka pašreiz vēl neesot skaidrs, kā izskatīsies valstu un uzņēmumu sadarbība. No viena vienīga Lex Facebook būtu maz jēgas. “Drīzāk, lai ieviestu gudru kārtību, vajadzētu izstrādāt apjomīgus atjauninājumus, kas aptvertu datu drošību, mediju likumdošanu, kā arī virkni pamattiesību (par cenzūru un vārda brīvību),” secina Lobo.“Izdzēst komentārus – tas ir vienkāršais risinājums,” saka Burharts. Viņam tas nešķiet konstruktīvi. “Tieši komentāriem jau minētajā pelēkajā zonā, pret kuriem nav iespējams vērsties ar juridisku pamatojumu, izdzēšana nepalīdz.” Zinātnieks uzskata, ka tā vietā, lai izņemtu komentāru, var mēģināt uzsākt diskusiju ar tā autoru un par to parunāt. “Vēlākais šajā posmā pie lietas jāķeras cilvēkiem. Tad mašīna pirms tam var tikai filtrēt un šķirot.”

Tomēr mediju valodniece Jaki uzskata, ka naidīgo komentāru cēlonis neesot atrisināms arī ar mākslīgā intelekta palīdzību: ”Bet daudz var panākt arī ar simptoma novēršanu. Kādas minoritātes naidīgie komentāri rada iespaidu, ka sabiedrība būtu sašķelta. Komentāru redzamības samazināšana tam noteikti var darboties pretī.“ Viens no interesantākajiem jautājumiem, kā uzsver zinātnieki, esot: ”Ko darīt ar sarkasmu?” Jo šīs kategorijas komentāri, protams, nav naidīgi, taču bieži vien atbilst naida runas kritērijiem.

“Izdzēst komentārus ir vienkāršais risinājums”

Šai problēmai ir pievērsušies Masačūsetsas Tehnoloģiju institūta pētnieki Kembridžā, kuri sākotnēji vēlējās radīt sistēmu, kas atpazītu rasistiskus komentārus Twitter vietnē. Tad komanda saprata, ka daudzus izteikumus nav iespējams kategorizēt, neņemot vērā sarkasmu. Uz dziļo mašīnmācīšanos balstītais algoritms DeepMoji trenējās ar 1,2 miljardiem Twitter ierakstu, kas turklāt saturēja kombināciju no 64 emocijzīmēm. Testā tam veicās labāk nekā cilvēkiem. Kamēr cilvēkiem, kas pārbaudīja, bija taisnība 76 procentos gadījumu, DeepMoji sasniedza 82 procentu precizitāti.

ASV koncerns Alphabet un tā meitas uzņēmums Google arī jau labu laiku strādā pie algoritma, kam būtu jāatpazīst ļauni un aizskaroši izteikumi un jāuzlabo komunikācija internetā. Šī projekta nosaukums ir Perspective, un to programmēja pētnieku iniciatīva Conversational AI. Tajā ir runa par algoritmu, kas patstāvīgi atpazīst naidīgos komentārus, turklāt nepārtraukti turpina mācīties. Lietojumprogrammas interfeiss (programmsaskarne) ar mašīnmācīšanās tehniku palīdzību atpazīst dažāda veida apvainojumus. Projekta mājaslapā par to teikts: “Mēs vēlamies noskaidrot, kā datori var iemācīties saprast šādu izteikumu nianses un kontekstu plašākā mērogā. Tad mašīnmācīšanās varētu palīdzēt izdevniecībām, publicētājiem internetā un moderatoriem labāk pārvaldīt komentārus savās platformās, un tādā veidā veicināt ideju apmaiņu internetā.” Pastāv sadarbība ar New York Times, The Guardian, The Economist un Vikipēdija.

Saskarne kalpo tam, lai algoritmu nodotu dažādiem pētniekiem, kuri attīsta rīkus naidīgu komentāru apkarošanai. 2017. gadā sākumā pirmais šāda veida projekts izveidoja slīdni, kas dažādu diskusiju komentārus novērtē skalā no 1 (ļoti konstruktīvi) līdz 100 (naida runa). Turklāt rīks ir analizējis dažādus izteikumus par tādām tēmām kā klimata pārmaiņas, Brexit un ASV vēlēšanas. Izteikuma “toksisko saturu” tas cenšas noteikt, aplūkojot teikumus pilnībā, tātad ne tikai tajos iekļutos atslēgvārdus.

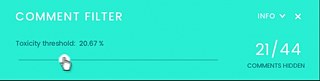

Cits digitālais paplašinājums ir komentāru filtrs, kas balstīts Perspective algoritmā. Tas ļauj lasītājiem izvēlēties, cik daudz šķietamu naidīgo komentāru viņi vēlas redzēt. Atkarībā no tā, uz kādu stiprumu filtrs ir iestatīts, lietotājam tiks apslēpts lielāks vai mazāks komentāru skaits. Pagaidām šie rīki ir pieejami tikai anglofonajās valstīs.

Teksts: meedia.de, Tomass Borgbēmers