Wie sich künstliche Intelligenz auf Sprache und Textproduktion auswirkt, und wieso diskriminierende Sprache schon in Schulen thematisiert werden muss, dazu sind in diesem Dossier verschiedene Perspektiven zusammengestellt. Sie waren der Auftakt zu Veranstaltungen, mit denen wir die Themen von Artificially Correct öffnen möchten und die Diskussion bereits dort beginnen, wo Textproduktion für viele beginnt: In der Schule.

Wir wissen zwar nicht, was uns die Algorithmen von morgen sagen werden, aber ihre Antworten basieren auf den Fragen, die wir stellen, und den Maßnahmen, die wir heute ergreifen. Es ist unsere Pflicht uns selbst und der Zukunft gegenüber sicherzustellen, dass sie gut sind.

Adam Smith

Die Schule als Institution trug und trägt dazu bei, dass gewisse Menschen unsichtbar waren oder sind. Es muss ein Umfeld geschaffen werden, in dem junge Menschen ihr Coming-out wagen und dafür nicht gemobbt werden – und das ist derzeit leider nicht der Fall.

Sovia Szymula

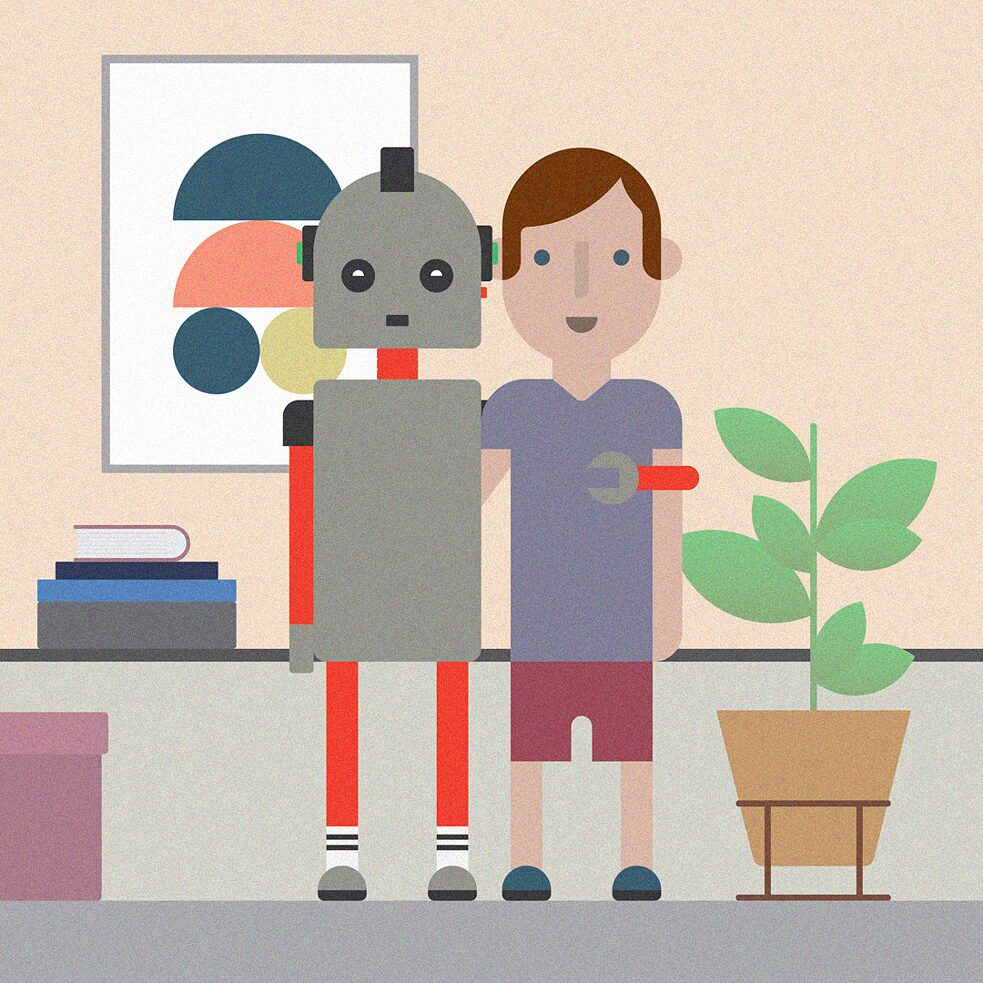

Sprache definiert die Welt. Das Goethe-Institut steht für eine inklusive Sprache – und damit für eine inklusive Welt.

Mit Artificially Correct entwickeln wir mit Expert*innen Tools, die den Bias in Texten minimieren und erhöhen das Bewusstsein für einen kritischen Umgang mit Sprache.

Konkret beschäftigt sich Artificially Correct mit KI-basierten Übersetzungs- und Schreibtools und den Verzerrungen (z.B. gender-/racial-Bias), die sie generieren können. Artificially Correct schafft ein aktives Netzwerk an Menschen, die dieses Problem betrifft – Übersetzer*innen, Aktivist*innen und Expert*innen – und identifiziert Partner, die das Thema gemeinsam mit uns langfristig verfolgen. Wir bündeln Perspektiven, schaffen Aufmerksamkeit, vermitteln Wissen und regen die Diskussion an.