Was ist eigentlich normal? Und was macht ein normales Gesicht aus? Unser Gehirn analysiert und klassifiziert jedes Gesicht, dem wir begegnen – und damit sind wir nicht allein. Eine gesamte wissenschaftlich-technische Disziplin analysiert solche unterbewussten kognitiven Prozesse und zerlegt sie in statistische Normalitäten. Maschinelles Lernen ermöglicht es sogar, mithilfe von Gesichtserkennung menschliches Verhalten einzuordnen und vorherzusagen.

Das sprechende Porträt

Im 19. Jahrhundert machte Paris eine dramatische Entwicklung durch: Die industrielle Revolution zog Dorfbewohner*innen an, die ihr Glück in der Großstadt versuchten, was einen Trend zur Verstädterung auslöste, der bis heute anhält. Zum ersten Mal in ihrem Leben fanden sich gebürtige Pariser*innen ebenso wie Neulinge jeden Tag von nie gesehenen, unbekannten Gesichtern umgeben. Zusammen mit der zunehmenden Kluft zwischen Industriebürgertum und Arbeiterklasse rüttelten diese demografischen Veränderungen am sozialen Gefüge der Stadt. Mit der zunehmenden Entfremdung zwischen den Bewohner*innen wuchsen auf den Straßen Angst und Kriminalität.

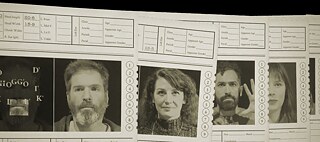

Sagen Sie uns, wer Sie sind, oder Ihr Porträt tut es: Seit der Erfindung des Fahndungsfotos ist es viel einfacher, Kriminelle zu identifizieren.

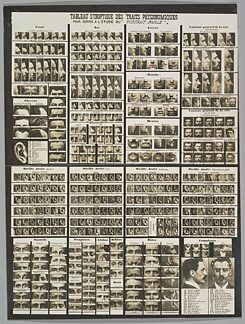

| Foto: © Tableau Synoptic des Traits Physionomiques: pour servir a l’étude du “Porträt Parlé”, by Alphonse Bertillon (1909) / public domain

In früheren Zeiten hatte ein Polizist normalerweise gewusst, wen er festnahm, wo der oder die Verdächtige wohnte und was die Mutter zum Fehlverhalten ihres Kindes sagen würde. Doch mit dem Zustrom neuer Gesichter änderte sich das. Auf den Polizeiwachen fing man an, Verhaftungen mithilfe der damals aufkommenden Fotografie zu dokumentieren. Allerdings häuften sich so unüberschaubare und damit unbrauchbare Bilderberge an. Der junge Pariser Polizist Alphonse Bertillon beschloss deshalb, Ordnung in das Chaos zu bringen. Er begann mit der Standardisierung der Polizeifotos, indem er stets ein frontales und ein seitliches Porträt aufnahm. Diese Bilder legte er auf einer standardisierten Karteikarte ab. Mit anderen Worten: Er erfand das moderne Polizeifoto – bis heute das Symbol schlechthin für das Verbrechen. Anschließend vermaß, quantifizierte und klassifizierte er den Körper der verhafteten Person und ergänzte die Karten um zusätzliche, spezifische Identifizierungsmerkmale. Bertillon schuf darüber hinaus ein System, das er portrait parlé nannte (sprechendes Porträt). Dieses sollte gewährleisten, dass eine festgenommene Person, die ihre Identität nicht preisgeben wollte, notfalls durch ihr Porträt verraten würde. Die Tabelle klassifizierte verschiedene Arten von Nasen, Mündern, Augen, Ohren sowie weitere Gesichtszüge und kategorisierte diese systematisch.

Sagen Sie uns, wer Sie sind, oder Ihr Porträt tut es: Seit der Erfindung des Fahndungsfotos ist es viel einfacher, Kriminelle zu identifizieren.

| Foto: © Tableau Synoptic des Traits Physionomiques: pour servir a l’étude du “Porträt Parlé”, by Alphonse Bertillon (1909) / public domain

In früheren Zeiten hatte ein Polizist normalerweise gewusst, wen er festnahm, wo der oder die Verdächtige wohnte und was die Mutter zum Fehlverhalten ihres Kindes sagen würde. Doch mit dem Zustrom neuer Gesichter änderte sich das. Auf den Polizeiwachen fing man an, Verhaftungen mithilfe der damals aufkommenden Fotografie zu dokumentieren. Allerdings häuften sich so unüberschaubare und damit unbrauchbare Bilderberge an. Der junge Pariser Polizist Alphonse Bertillon beschloss deshalb, Ordnung in das Chaos zu bringen. Er begann mit der Standardisierung der Polizeifotos, indem er stets ein frontales und ein seitliches Porträt aufnahm. Diese Bilder legte er auf einer standardisierten Karteikarte ab. Mit anderen Worten: Er erfand das moderne Polizeifoto – bis heute das Symbol schlechthin für das Verbrechen. Anschließend vermaß, quantifizierte und klassifizierte er den Körper der verhafteten Person und ergänzte die Karten um zusätzliche, spezifische Identifizierungsmerkmale. Bertillon schuf darüber hinaus ein System, das er portrait parlé nannte (sprechendes Porträt). Dieses sollte gewährleisten, dass eine festgenommene Person, die ihre Identität nicht preisgeben wollte, notfalls durch ihr Porträt verraten würde. Die Tabelle klassifizierte verschiedene Arten von Nasen, Mündern, Augen, Ohren sowie weitere Gesichtszüge und kategorisierte diese systematisch.

Für Bertillon war es schlicht ein Indexierungssystem, das die Identifizierung erleichtern sollte. Und tatsächlich verbreitete sich die „Bertillonage“ schnell in Europa und den USA als bahnbrechende, wissenschaftlich fundierte erkennungsdienstliche Methode. Aber nur wenige Jahre später wurde diese zu Bertillons Enttäuschung durch den Fingerabdruck ersetzt, eine viel einfachere und genauere Technologie.

Was ist eigentlich normal?

Die Untersuchung des Fingerabdrucks gehörte zu den vielen wissenschaftlichen Beiträgen von Sir Francis Galton, einem umtriebigen britischen Intellektuellen und Statistikpionier. Eine weitere wichtige Entdeckung Galtons war die Normalverteilung. Er beobachtete, dass scheinbar zufällige Phänomene oft ein Wahrscheinlichkeitsmuster zeigten, das um eine gekrümmte Spitze in Form einer Glocke verteilt ist – die „Glockenkurve“. Diese Phänomene verschmelzen meist näher an der Spitze der Glockenkurve als an ihren Rändern.

Nachbildung der Galton-Box: Die Verteilung der fallenden Bohnen entspricht immer der Glockenkurve.

| Foto: © CC BY-SA 4.0

Dieses eher abstrakte statistische Phänomen demonstrierte Galton mit einem eigenartigen Gerät, das einem Flipperautomaten ähnelte. Er füllte es mit Bohnen. Am oberen Rand des Bretts wurden die Bohnen in einen einzigen Auslass in der Mitte geleitet, von wo aus sie auf eine Reihe von Stiften stießen. Die Bohnen wurden auf ihrem Weg zwischen den Stiften hin- und hergeschleudert. Am Ende landeten sie in Öffnungen, die gleichmäßig entlang der Basis des Bretts verteilt waren. Es gab keine Möglichkeit, genau vorherzusagen, welche Bohne in welche Öffnung fallen sollte. Dennoch wiederholte sich die Gesamtverteilung stets in Form der Glockenkurve. Die mittlere Öffnung enthielt dabei die meisten Bohnen; je weiter eine Öffnung links oder rechts lag, desto weniger Bohnen landeten dort. Die Quantifizierung der Normalverteilung ermöglichte auch die Quantifizierung von Standardabweichungen – dem Grad der Streuung über alle Öffnungen. Eine geringe Standardabweichung bedeutete, dass die Öffnungen näher an der Norm lagen, dem Höhepunkt der Kurve. Bei einer höheren Standardabweichung waren sie weiter verteilt und Anomalien waren wahrscheinlicher.

Nachbildung der Galton-Box: Die Verteilung der fallenden Bohnen entspricht immer der Glockenkurve.

| Foto: © CC BY-SA 4.0

Dieses eher abstrakte statistische Phänomen demonstrierte Galton mit einem eigenartigen Gerät, das einem Flipperautomaten ähnelte. Er füllte es mit Bohnen. Am oberen Rand des Bretts wurden die Bohnen in einen einzigen Auslass in der Mitte geleitet, von wo aus sie auf eine Reihe von Stiften stießen. Die Bohnen wurden auf ihrem Weg zwischen den Stiften hin- und hergeschleudert. Am Ende landeten sie in Öffnungen, die gleichmäßig entlang der Basis des Bretts verteilt waren. Es gab keine Möglichkeit, genau vorherzusagen, welche Bohne in welche Öffnung fallen sollte. Dennoch wiederholte sich die Gesamtverteilung stets in Form der Glockenkurve. Die mittlere Öffnung enthielt dabei die meisten Bohnen; je weiter eine Öffnung links oder rechts lag, desto weniger Bohnen landeten dort. Die Quantifizierung der Normalverteilung ermöglichte auch die Quantifizierung von Standardabweichungen – dem Grad der Streuung über alle Öffnungen. Eine geringe Standardabweichung bedeutete, dass die Öffnungen näher an der Norm lagen, dem Höhepunkt der Kurve. Bei einer höheren Standardabweichung waren sie weiter verteilt und Anomalien waren wahrscheinlicher.

Diese praktische mathematische Formulierung trug dazu bei, dass die statistische Normalität viel mehr als nur ein wissenschaftlicher Standard wurde. Galton strebte danach, jeden Aspekt des Lebens durch die statistische Brille zu betrachten. Bald schon sollte sein Normalitätsbegriff über die Naturwissenschaften hinaus Anwendung finden. Vor Galtons Forschungen am Ende des 19. Jahrhunderts war es sehr ungewöhnlich, das Wort „normal“ zu verwenden, um etwas außerhalb der Naturwissenschaften zu beschreiben. Gleichzeitig wurde der Begriff der Normalität selbst schnell normalisiert. Durch die Arbeit von Émile Durkheim und anderen Soziolog*innen hielt er Einzug in die Sozialwissenschaften und die Alltagskultur.

Normales oder abweichendes Gesicht?

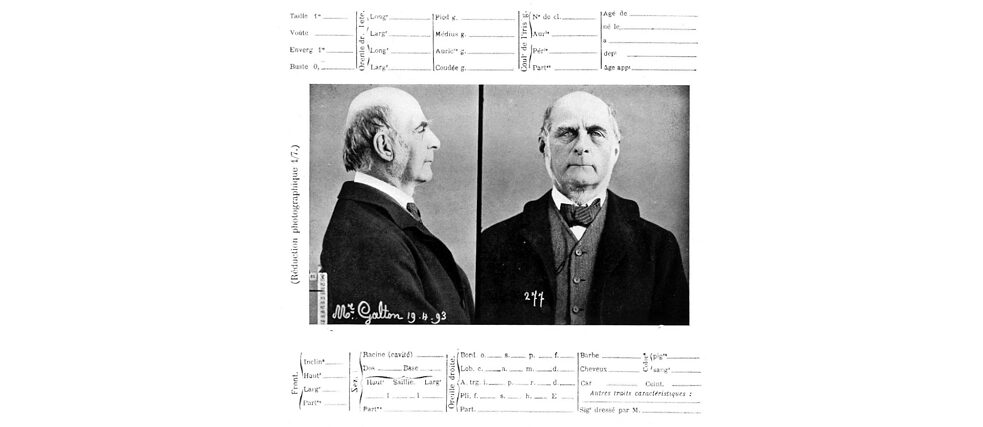

1893 besuchte Galton das forensische Labor von Bertillon und war begeistert. Es interessierte ihn nicht, was Bertillons Werkzeuge und Methoden über die Verantwortung von Einzelpersonen für vergangene Verbrechen aufdecken konnten. Vielmehr wollte er künftige Abweichungen statistisch vorraussagen.

Foto und Bertillon-Aufzeichnung von Francis Galton (damals 73), erstellt bei dessen Besuch in Bertillons Labor 1893.

| Foto: © Wikipedia/gemeinfrei

Wie Bertillon widmete sich Galton der systematischen Auseinandersetzung mit dem fotografierten Porträt. Seine Erkenntnisse zur statistischen Normalität regten Galton an, die Technik der zusammengesetzten Porträtmalerei zu entwickeln. Bei dieser Technik wurden verschiedene Motive auf derselben Filmplatte mit geringer Belichtung fotografiert. So entstand ein einziges, gemischtes Bild. Er schuf zusammengesetzte Porträts von Armeeoffizieren und königlichen Ingenieuren, von Kriminellen und Menschen mit psychischen Erkrankungen. Galton versuchte herauszufinden, wie normale Menschen typischerweise aussahen, und Möglichkeiten, soziale Standardabweichungen zu finden und letztlich vorherzusagen.

Foto und Bertillon-Aufzeichnung von Francis Galton (damals 73), erstellt bei dessen Besuch in Bertillons Labor 1893.

| Foto: © Wikipedia/gemeinfrei

Wie Bertillon widmete sich Galton der systematischen Auseinandersetzung mit dem fotografierten Porträt. Seine Erkenntnisse zur statistischen Normalität regten Galton an, die Technik der zusammengesetzten Porträtmalerei zu entwickeln. Bei dieser Technik wurden verschiedene Motive auf derselben Filmplatte mit geringer Belichtung fotografiert. So entstand ein einziges, gemischtes Bild. Er schuf zusammengesetzte Porträts von Armeeoffizieren und königlichen Ingenieuren, von Kriminellen und Menschen mit psychischen Erkrankungen. Galton versuchte herauszufinden, wie normale Menschen typischerweise aussahen, und Möglichkeiten, soziale Standardabweichungen zu finden und letztlich vorherzusagen.

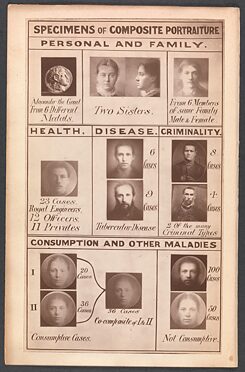

Galton untersuchte Porträts von Kriminellen und psychisch kranken Menschen, um herauszufinden, wie normale Menschen typischerweise aussahen.

| Foto: © Frontispiece of Inquiries into Human Faculty and its Development, Francis Galton (1883) / public domain

Für Galton war Statistik mehr als ein intellektuelles Unterfangen: Er hielt es für machbar, mithilfe der statistischen Normalität eine bessere Gesellschaft zu schaffen. Er gründete die Eugenik‑Bewegung. Diese versuchte, Evolution und natürliche Selektion (die wissenschaftlichen Durchbrüche von Galtons Cousin zweiten Grades, Charles Darwin) nicht als Analyse der Variabilität in der Natur zu betrachten, sondern als Rezept für die Schaffung einer besseren Gesellschaft. Eugeniker*innen wie Galton praktizierten die Physiognomie – die Pseudowissenschaft der Beurteilung von Persönlichkeitsmerkmalen anhand der körperlichen Erscheinung. Das ist, als würde man ein Buch nach seinem Einband beurteilen. Mithilfe von Bertillons „datafication“ (Messen und Aufzeichnen in Form von Daten) und seiner Körper‑Kategorisierung wollten sie analysieren, einstufen und vorhersagen, welchen Beitrag zur Gesellschaft eine Person leisten konnte und welchen Einfluss er auf den Genpool künftiger Generationen haben würde. Eugeniker*innen glaubten, vor allem die Natur und nicht etwa die Erziehung (oder Gott) beeinflusse das menschliche Schicksal. Daher bringe es der Menschheit den größten Fortschritt, wenn sie die Reinheit des Erbes bewahre und von der Norm Abweichende an der Fortpflanzung hindere. Bald schon wurde in ganz Westeuropa und Großbritannien die Eugenik politisch vorangetrieben. Doch es waren die amerikanischen Eugeniker*innen, die als erste Sterilisationsgesetze erließen, um Menschen mit Behinderung davon abzuhalten, Kinder zu bekommen.

Galton untersuchte Porträts von Kriminellen und psychisch kranken Menschen, um herauszufinden, wie normale Menschen typischerweise aussahen.

| Foto: © Frontispiece of Inquiries into Human Faculty and its Development, Francis Galton (1883) / public domain

Für Galton war Statistik mehr als ein intellektuelles Unterfangen: Er hielt es für machbar, mithilfe der statistischen Normalität eine bessere Gesellschaft zu schaffen. Er gründete die Eugenik‑Bewegung. Diese versuchte, Evolution und natürliche Selektion (die wissenschaftlichen Durchbrüche von Galtons Cousin zweiten Grades, Charles Darwin) nicht als Analyse der Variabilität in der Natur zu betrachten, sondern als Rezept für die Schaffung einer besseren Gesellschaft. Eugeniker*innen wie Galton praktizierten die Physiognomie – die Pseudowissenschaft der Beurteilung von Persönlichkeitsmerkmalen anhand der körperlichen Erscheinung. Das ist, als würde man ein Buch nach seinem Einband beurteilen. Mithilfe von Bertillons „datafication“ (Messen und Aufzeichnen in Form von Daten) und seiner Körper‑Kategorisierung wollten sie analysieren, einstufen und vorhersagen, welchen Beitrag zur Gesellschaft eine Person leisten konnte und welchen Einfluss er auf den Genpool künftiger Generationen haben würde. Eugeniker*innen glaubten, vor allem die Natur und nicht etwa die Erziehung (oder Gott) beeinflusse das menschliche Schicksal. Daher bringe es der Menschheit den größten Fortschritt, wenn sie die Reinheit des Erbes bewahre und von der Norm Abweichende an der Fortpflanzung hindere. Bald schon wurde in ganz Westeuropa und Großbritannien die Eugenik politisch vorangetrieben. Doch es waren die amerikanischen Eugeniker*innen, die als erste Sterilisationsgesetze erließen, um Menschen mit Behinderung davon abzuhalten, Kinder zu bekommen.

Bertillon selbst wollte nie, dass seine Technologie so eingesetzt wird. Als er mit den wissenschaftlichen Rassismustheorien des zeitgenössischen italienischen Kriminologen Cesare Lombroso konfrontiert wurde, sagte Bertillon: „Nein. Ich bin nicht überzeugt, dass der Mangel an Symmetrie im Gesicht oder die Größe der Augenhöhle oder die Form des Kiefers einen Menschen zu einem Übeltäter macht.“

Bertillon argumentierte, er habe in seinem forensischen Labor sehr viele Gesichter gesehen. Zum Beispiel, sagte er weiter, deute ein Augenfehler nicht darauf hin, dass die Person schon als Kriminelle*r geboren worden sei, sondern dass ihr schlechtes Sehvermögen ihr möglicherweise nur wenige Alternativen auf dem Arbeitsmarkt gelassen habe.

Bertillon stellte den Körper in Form von Daten dar, um vergangenes Verhalten zu identifizieren und zu korrelieren. Es ging ihm keineswegs darum, künftige Handlungen zu erahnen oder vorherzusagen. Allerdings ermöglichte genau diese Datenerfassung und Kategorisierung von Verhalten und persönlichen Merkmalen sowohl eine forensische Identifizierung als auch eine statistische Vorhersage. Wissenschaftlich sanktionierter Rassismus und Physiognomie sollten das 20. Jahrhundert prägen. In seinem Buch Mein Kampf bezieht sich Adolf Hitler auf US-amerikanische Eugenik als wichtige Voraussetzung für das, was sich in Deutschland später zur Nazi-Eugenik entwickeln sollte. Ihren grauenvollen Höhepunkt erreichte diese Denkweise und Praxis mit der Massenvernichtung und dem Genozid an Jüd*innen, Roma, Homosexuellen, Menschen mit Behinderung und anderen, die als abweichend vom normalisierten rassistischen Arier*innenbild gekennzeichnet waren. Nach der Niederlage der Nationalsozialst*innen im Zweiten Weltkrieg wurden die Ideen der Physiognomie und des wissenschaftlichen Rassismus international verurteilt. In den Folgejahren schlummerten sie unter der Oberfläche, doch sie verschwanden nicht, denn sie waren tief in das Erbe der statistischen Normalität eingewoben.

Das Porträt spricht wieder

Durch die rasanten Fortschritte in der computergestützten Statistik erlebte die Gesichtsanalyse im zweiten Jahrzehnt des 21. Jahrhunderts ein dramatisches Comeback. Die heutigen „Data Scientists“ sind direkte intellektuelle Nachfahren der Statistik- und Datafication-Pioniere des 19. Jahrhunderts. Einige von ihnen konzentrieren sich auf die Identifizierung von Personen und nehmen Bertillons Versuche wieder auf, Personen forensisch zu identifizieren, indem sie alte und neue Daten abgleichen. Andere konzentrieren sich wie Galton auf die Analyse und versuchen, künftiges Verhalten anhand von Mustern aus der Vergangenheit statistisch vorherzusagen. Heute werden Identifizierung und Vorhersage häufig kombiniert, um die Technologie optimal zu nutzen. So kündigte Facebook auf behördlichen Druck hin im November 2021 an, die Gesichtserkennung zur Identifizierung von Benutzer*innen in Bildern einzustellen. Das Unternehmen erwähnte, dass dies Auswirkungen auf seinen „Automatic Alt Text“-Dienst haben werde, der Bilder analysiert, um deren Inhalt automatisch in Textform zu beschreiben.

Rechenzentren sammeln immer mehr Daten an. Sie zeichnen ein immer genaueres Porträt unseres bisherigen Verhaltens, das dann algorithmische Vorhersagen speist. Ähnlich wie bei Galtons zusammengesetzten Porträts wird das Bild des normalen Verhaltens aus mehreren überlagerten Mustern verschiedener Personen konstruiert. Jede Information durchläuft dabei eine algorithmische Blackbox, um dann ihren Weg in die Glockenkurve des künftigen normalisierten Verhaltens zu finden. Normalisierung durch Daten wird zur selbst erfüllenden Prophezeiung. Sie sagt nicht nur die Zukunft voraus, sondern sie diktiert die Zukunft. Wenn es am sichersten ist, auf den vorhergesagten Weg zu setzen, wird die Wette auf eine Abweichung zum finanziellen, kulturellen und mitunter auch politischen Risiko. So normalisieren datengesteuerte Vorhersagen die Vergangenheit und verhindern Veränderungen. Algorithmen für maschinelles Lernen sind daher von Natur aus konservativ: Sie können nur vorhersagen, wie Muster aus der Vergangenheit wiederholen werden, aber nicht, wie sie sich entwickeln könnten.

Der Diskurs über Online-Datenschutz beeinflusst immer noch die Diskussion über das Recht einer Person, frühere Aktivitäten geheim zu halten. Doch die heutigen algorithmischen Überwachungsapparate interessieren sich nicht unbedingt für unsere früheren persönlichen Aktivitäten. Sie interessieren sich für das Bild, das unsere zusammengesetzten Porträts offenbaren – jenes Bild, das den Weg der Normalität definiert und Abweichungen von der Norm verdächtig macht.

Online-Normalisierung

Wie Maschinen kategorisieren auch wir Menschen ständig fremde Gesichter. Wir erfassen, kategorisieren und analysieren die physiognomischen Merkmale unseres Gegenübers. Aber sind wir uns unserer alltäglichen Vorurteile bewusst, der Art und Weise, wie wir ständig definieren, was normal ist und was nicht? Wie kategorisieren wir Menschen und wie werden wir kategorisiert? Genau darum geht es beim Projekt Normalizi.ng. Bei diesem experimentellen Online-Forschungsprojekt hilft maschinelles Lernen, zu analysieren und zu verstehen, wie wir entscheiden, wer „normaler“ aussieht.

Wer an Normalizi.ng teilnimmt, durchläuft drei Schritte, die schon sehr lange typisch für die Statistikanalyse sind. Im ersten Schritt – capture (Erfassung) – werden die Proband*innen aufgefordert, ihre Gesichter in einen Rahmen zu halten und ein Selfie aufzunehmen. Im zweiten Schritt – classify (Kategorisieren) – sehen sie einige zuvor erfasste Teilnehmende. Sie wischen dann nach rechts und links, um zwischen je zwei Bildern eine Auswahl zu treffen: Welche Nase, welcher Mund, welches Augenpaar und welches Gesicht sieht „normaler“ aus? Im dritten Schritt – der Analyse – untersucht der Algorithmus ihre Gesichter und ihre Normalisierungsentscheidungen. Diese werden, ähnlich wie bei der Bertillonage, auf einer Karteikarte mit dynamischen Normalisierungswerten abgelegt. Die Gesichter der Proband*innen werden anschließend einer vom „portrait parlé“ inspirierten algorithmischen Karte der Normalität hinzugefügt.

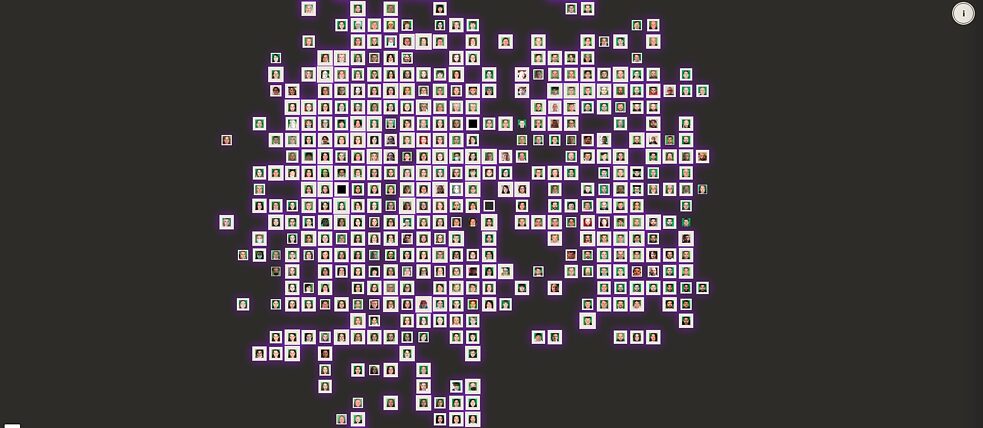

The Normalizi.ng Map

| The Normalizi.ng Map

Mithilfe eines Gesichtsanalyse-Algorithmus werden Gesichter mit ähnlichen Merkmalen auf einem zweidimensionalen Gitter gruppiert. Je höher der Normalitätswert ist, desto dicker wird der Porträtrahmen. Sofern mehr Teilnehmende hinzukommen, aktualisiert der Algorithmus die Karte stündlich und zeichnet sie dann neu. Doch in jeder Karte sind die beiden Hauptcluster immer eindeutig als männlich und weiblich gekennzeichnet. Andere Cluster werden an den Rändern gebildet: ein dunkelhäutiger Cluster, der oft sowohl für Männer als auch für Frauen einheitlich ist, ein asiatischer Cluster, der manchmal allmählich in einen Latinx-Cluster übergeht. Ein Kinder-Cluster, ein Senior*innen‑Cluster, ein Bart-Cluster ... Interessanterweise sind pandemie‑maskierte Gesichter gleichmäßig über die Karte verteilt. Während die algorithmischen Karten ständig neu gezeichnet werden, wiederholen und verstärken sie die Einteilung der Gesichter. So wird sichtbar, wie die heutige systematische Diskriminierung in Gesellschaften auf der gesamten Welt nach Geschlecht, Hautfarbe, Alter oder Haarstil aggregiert, verstärkt und bequem hinter der scheinbar objektiven Blackbox der künstlichen Intelligenz versteckt wird.

The Normalizi.ng Map

| The Normalizi.ng Map

Mithilfe eines Gesichtsanalyse-Algorithmus werden Gesichter mit ähnlichen Merkmalen auf einem zweidimensionalen Gitter gruppiert. Je höher der Normalitätswert ist, desto dicker wird der Porträtrahmen. Sofern mehr Teilnehmende hinzukommen, aktualisiert der Algorithmus die Karte stündlich und zeichnet sie dann neu. Doch in jeder Karte sind die beiden Hauptcluster immer eindeutig als männlich und weiblich gekennzeichnet. Andere Cluster werden an den Rändern gebildet: ein dunkelhäutiger Cluster, der oft sowohl für Männer als auch für Frauen einheitlich ist, ein asiatischer Cluster, der manchmal allmählich in einen Latinx-Cluster übergeht. Ein Kinder-Cluster, ein Senior*innen‑Cluster, ein Bart-Cluster ... Interessanterweise sind pandemie‑maskierte Gesichter gleichmäßig über die Karte verteilt. Während die algorithmischen Karten ständig neu gezeichnet werden, wiederholen und verstärken sie die Einteilung der Gesichter. So wird sichtbar, wie die heutige systematische Diskriminierung in Gesellschaften auf der gesamten Welt nach Geschlecht, Hautfarbe, Alter oder Haarstil aggregiert, verstärkt und bequem hinter der scheinbar objektiven Blackbox der künstlichen Intelligenz versteckt wird.

Unbekannte Gesichter sind ein wesentlicher Grund, dass Paris und viele andere Metropolen so aufregend sind und eine Fülle an Chancen bieten. Paris wird nie wieder eine homogene Kleinstadt sein. Das Internet auch nicht. Der Algorithmus ist der Polizist, der dich nur als ein Stereotyp sieht, dich nie persönlich kennt und auch nicht mit deiner Mutter spricht. Halten wir inne und fragen uns: Wollen wir das systematisieren? Automatisieren? Verstärken? Und sollte Normalität überhaupt ein Thema für die Polizei sein?

März 2022