Demokratie im digitalen Raum

„Sei vorsichtig, was du erschaffst!”

Die Menschenrechtsanwältin und Autorin Maureen Webb erklärt, wie technische Lösungen Diskriminierung verschärfen können – und wie Hacker*innen sich dafür einsetzen, die demokratischen Grundrechte im digitalen Raum zu bewahren.

Von Johannes Zeller

Frau Webb, in Ihrem Buch „Coding Democracy“ beschreiben Sie Hacker*innen als produktive Störer*innen, die sich gegen Überwachung, Machtkonzentration und Autoritarismus einsetzen. Sie argumentieren auch, dass Hacker*innen uns dabei helfen können, die „Informationsdysphorie“ zu überwinden, die die Gesellschaft im Moment plagt. Was meinen Sie damit?

Informationsdysphorie beschreibt das Unbehagen, mit dem wir im Westen gerade konfrontiert sind – den Zustand der Orientierungslosigkeit, den wir in einer digitalen Welt empfinden, in der unsere Informationen und sozialen Beziehungen zunehmend von unsichtbaren Kräften gesteuert werden. Es ist eine neutralere Bezeichnung als Fake News, Fehlinformation, Desinformation, Voreingenommenheit oder Diskriminierung, obwohl es all diese Probleme beinhaltet. In der Pathologie bezeichnet „Dysphorie“ einen Zustand von Angst, Depression und – ich denke das ist in unserer gegenwärtigen politischen Situation sehr relevant – von „Ungeduld in der Not“.

Was sind diese „unsichtbaren Kräfte“, von denen Sie sprechen?

Dafür gibt es viele Beispiele: Algorithmen, die undurchsichtige Entscheidungen treffen und uns sozial sortieren. Big Data mit seinen vielen ungeprüften Annahmen, die täglich mehr Governance-Funktionen übernehmen. Narrowcasting, bei dem Medien immer kleinere Fragmente der Gesellschaft bedienen. Politisches Microtargeting, wie wir es im Cambridge-Analytica-Skandal rund um die US-Präsidentschaftswahl 2016 und die Brexit-Abstimmung gesehen haben. Influence campaigns (Social-Media-Kampagnen, die darauf ausgerichtet sind, die Meinungen und Entscheidungen von Menschen zu beeinflussen, Anmerkung der Redaktion), die ihren wahren Ursprung verbergen. Virale Fehlinformationskampagnen, der Aufstieg von Deepfakes … um nur ein paar Beispiele zu nennen.

In welchem Ausmaß wird Informationsdysphorie als politische Taktik eingesetzt?

Demokratie braucht abwägenden, faktenbasierten Diskurs. Die Bevölkerung in Informationsdysphorie zu versetzten, ist eine alte Taktik autoritärer Regime, die, verstärkt durch die digitalen Medien, in den letzten Jahren auch westliche Demokratien unterwandert hat. Man füllt den öffentlichen Raum mit Unwahrheiten und widerspricht sich selbst die ganze Zeit. Dann weiß niemand mehr, was wirklich wahr ist, und die Machthabenden sind in der Position, die Symbole des Tages festzulegen. Symbole umgehen Debatte und Diskurs, weil sie direkt die Emotionen der Menschen berühren, ihre Sorgen, ihre Werte, sowie Verlust- und Erlösungsmythen. Informationsdysphorie wird auch eingesetzt, um Massenüberwachung und Zensur zu fördern. Um die Informationswelt zu „reparieren“, beginnen Regierungen und Eliten eng mit monopolistischen Plattformen zusammenzuarbeiten, um zu kontrollieren, was die Bevölkerung hören, denken oder sagen kann. Das zerstört den Diskurs und die Demokratie.

Wird Informationsdysphorie auch von den weniger Mächtigen eingesetzt?

Man könnte sagen, dass es eine Taktik des politischen Widerstandes ist, die herrschende Elite in Informationsdysphorie zu versetzen. In einer Reihe von Blogbeiträgen, die er vor dem Start von WikiLeaks geschrieben hat, erklärte Julian Assange seine Theorie, dass Leaking (insbesondere im großen Stil) emanzipatorisch ist. Nicht nur, weil es Geheimnisse aufdeckt, die die Bürger*innen wissen müssen, sondern auch, weil es die Kommunikation zwischen den Mächtigen erdrosselt und sie verwirrt.

Hacker*innengruppen wie der deutsche Chaos Computer Club (CCC) setzen sich schon lange gegen Überwachung und für mehr Transparenz ein, richtig?

Ja, und sie haben eine weitere brillante Verwirrungstaktik eingesetzt: Humor! Zum Beispiel, als viele Regierungen in den frühen Tagen des „Kriegs gegen den Terror“ biometrische Ausweise einführen wollten. Da hat der CCC die Fingerabdrücke des damaligen deutschen Innenministers Wolfgang Schäuble gestohlen und in einem Magazin veröffentlicht – gedruckt auf einen Plastikfilm, den Leser*innen verwenden konnten, um sich bei Sicherheitskontrollen als der Minister auszugeben. Das war ein sehr humorvoller Weg, um die Schwachstellen solcher Systeme aufzuzeigen und darauf einzuwirken, wie die Bevölkerung – und der Minister – über solche Systeme denkt.

Wie machen sich Voreingenommenheit und Diskriminierung in digitalen Technologien bemerkbar?

Sehen wir uns ein vieldiskutiertes Beispiel an: die Algorithmen um uns herum, die entscheiden, wer einen Kredit bekommt, ein Vorstellungsgespräch oder eine Versicherung und zu welchem Preis. Diese Algorithmen sind nicht automatisch fair. Voreingenommenheit und Diskriminierung werden so häufig ungeprüft repliziert. In der analogen Welt haben wir unterschiedliche Wege entwickelt, solche Voreingenommenheit zu adressieren und aufzustöbern. Doch in der digitalen Welt ist der Code häufig eine „Blackbox“ und nur wenige Menschen verstehen, was genau in dieser Box vor sich geht. Beim maschinellen Lernen wissen es manchmal nicht mal mehr die Entwickler*innen selbst.

Haben Sie ein Beispiel dafür, wie digitale Voreingenommenheit die Entscheidungen und das Leben der Menschen beeinflusst?

Amazon hat früher einen Algorithmus verwendet, um Softwareingenieur*innen anzustellen, und es hat sich gezeigt, dass der Mechanismus ausschließlich Lebensläufe von Männern auswählt. Der Grund dafür war, dass die Lebensläufe von bereits vorhandenen Mitarbeiter*innen genutzt wurden, um die Einstellungskriterien zu bestimmen. Die Voreingenommenheit war also schon in den historischen Daten vorhanden und wurde vom Algorithmus repliziert.

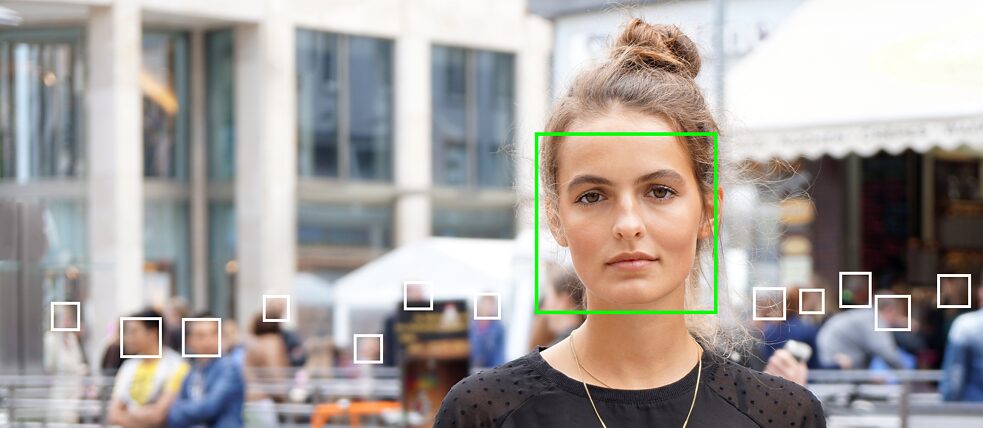

Könnte dasselbe mit Technologien geschehen, die von Regierungen eingesetzt werden – zum Beispiel bei Gesichtserkennungssoftware?

Eine Studie, die zwei große Gesichtserkennungsprogramme untersucht hat, hat herausgefunden, dass sie das Geschlecht einer Person nur in einem Prozent der Fälle falsch einschätzten, wenn die Person ein weißer Mann war. Bei dunkelhäutigen Frauen lag die Fehlerquote hingegen bei 35 Prozent. Der Grund dafür ist, dass die Programmierer*innen den Algorithmus mit einem Datenset gefüttert haben, das hauptsächlich aus Menschen bestand, die so aussahen wie sie selbst. Das ist besorgniserregend, wenn man bedenkt, dass unser Strafrechtssystem und andere Durchsetzungssysteme sich zunehmend auf Algorithmen verlassen, um Entscheidungen zu treffen. Und dass es in einem vollautomatisierten System keinen Rechtsbehelf, kein menschliches Urteil, keine Gnade oder Diskretion gibt.

Warum stößt der Einsatz von diskriminierender Technologie nicht auf mehr öffentlichen Widerstand?

Zum einen, weil sich das alles im Verborgenen abspielt und wenig verstanden wird. Außerdem sind Menschen ungeduldig – sie wünschen sich eine Wunderwaffe, die alle Probleme löst, und sind nur allzu bereit, auf illiberale Impulse zu reagieren. Das betrifft uns alle. Wir müssen den Mut haben, diese Phänomene ganz unparteiisch zu betrachten. Ich denke, es ist extrem wichtig, dass auch Progressive erkennen, dass sie voreingenommen sind. Zensur durch Suchalgorithmen ist die Waffe der Wahl geworden, um Meinungen, Fragen und Debatten zu entgegnen, die Progressiven nicht gefallen. Ich spreche hier als Teil der Linken, als Gewerkschafterin und Menschenrechtsanwältin. Wir verbreiten ebenfalls Voreingenommenheit über technische Prozesse. Es gibt Situationen, in denen wir denken, dass wir das Richtige tun – aber eigentlich richten wir Schaden an.

Zum Beispiel?

Zum Beispiel gab es eine Hollywood-App, die das Ziel hatte, die Diskriminierung von Schwarzen in der Filmindustrie zu bekämpfen. Die App begann als eine einfache Datenbank von Schwarzen Menschen, die in dieser Branche arbeiten. Der nächste Schritt, den die Entwickler*innen geplant hatten, war, für die Studios eine demografische Aufschlüsselung der ethnischen Zugehörigkeit aller Angestellten einer Produktion zu erstellen. In einem Vortrag am Goethe-Institut San Francisco habe ich argumentiert, dass das eine ganz schlechte Idee sein könnte – und zwar aus Sicht der Menschen- und Arbeitsrechte.

Was war das Problem mit dieser Hollywood-App?

Ich bin absolut für größere Teilhabe von Minderheiten am Arbeitsplatz auf allen Ebenen. Aber ich musste fragen: Wenn ihr eine demografische Aufschlüsselung der Identität aller Angestellten anbietet, welche Kategorien verwendet ihr? Nicht nur Ethnie und Geschlecht, sondern auch Familie, Religion und sozio-ökonomischen Status? Die Menschenrechte schützen diese Daten. Zielt ihr auf proportionale Anteilnahme ab und wie lässt sich diese erreichen, wenn man bedenkt, dass jeder Mensch multiple, sich überschneidende Identitätsmerkmale hat, die zusammen viel mehr ergeben als 100 Prozent? Außerdem haben Angestellte ein Recht auf Privatsphäre. Es gibt viele Gründe, warum sie ihren Arbeitsgeber*innen nicht alle Bestandteile ihrer Identität preisgeben möchten. Dazu gehört auch die Angst, übergangen zu werden, wenn Studios wissen, dass sie eine Behinderung oder Vorstrafen haben. Das führt uns zur Frage: Was ist mit denen, die nicht mitmachen wollen? Wollt ihr wirklich jeden Angestellten zwingen, einen Ausweis mitzuführen – einen Rassenausweis –, nur weil unsere Informationsgesellschaft dazu in der Lage ist, so ein System zu errichten? Was als gute, progressive Idee beginnt, kann sich schnell in eine schlechte Idee mit unerwünschten Konsequenzen entwickeln, wenn wir uns zu sehr auf „technische Lösungen“ verlassen.

Progressive Regierungen haben gerade so eine „technische Lösung“ in Form des Impfzertifikats eingeführt. Könnte das auch unerwünschte Konsequenzen haben?

Das ist ein weiteres wichtiges Beispiel, bei dem Progressive ihre eigene Voreingenommenheit ganz leicht übersehen. Innerhalb kürzester Zeit haben westliche Regierungen (im Vertrauen auf ihre eigene Tugend und überlegene Intelligenz) weite Teile der Gesellschaft dazu gebracht, Massenüberwachung und ein soziales Kreditsystem nach chinesischem Vorbild zu akzeptieren. Wenn diese Regierungen legitime Ziele im Bereich der öffentlichen Gesundheit verfolgen würden, hätten sie temporäre Einwegkarten mit Fälschungsschutz verwenden können, so wie Geldscheine, Führerscheine oder Versicherungskarten. Stattdessen haben sie sich für eine mobile App mit einem QR-Code entschieden, der persönliche und medizinische Daten speichert. Sie haben ein im Westen beispielloses System aufgebaut, das sehr wahrscheinlich expandieren wird – inhaltlich und zeitlich. Was ich sagen will, ist, dass digitale Werkzeuge, die uns sozial sortieren, in jedermanns Händen gefährlich sind. Es sind Werkzeuge zur sozialen Kontrolle, die mit maschineller Logik und ohne humanistische Sensibilität funktionieren, und ihr Einsatz hat Folgen, die oft weit über die Vorstellungen der Entwickler*innen hinaus gehen. Mein dringender Rat ist: Sei vorsichtig, was du erschaffst! Eine Gesellschaft muss sorgsam abwägen, welche Systeme sie erschafft.

Digitale Werkzeuge, die uns sozial sortieren, sind in jedermanns Händen gefährlich. Es sind Werkzeuge zur sozialen Kontrolle, die mit maschineller Logik und ohne humanistische Sensibilität funktionieren, und ihr Einsatz hat Folgen, die oft weit über die Vorstellungen der Entwickler*innen hinaus gehen.

In Ihrem Buch argumentieren Sie, dass ausgerechnet Hacker*innen die besten Lösungen für all diese demokratischen Herausforderungen finden.

Ich denke, Hacker*innen sind auf der richtigen Spur, und zwar mehr als andere Gruppen. Und ich denke nicht, dass uns engstirnige, technische Lösung aus der Misere herausführen können. Hacker*innen kämpfen seit drei Jahrzehnten für fundamentale Governance- und Ethik-Prinzipien im digitalen Zeitalter. Progressive Hacker*innen wünschen sich verteilte Macht, verteilte Entscheidungsfindung und verteilte Demokratie. Sie wollen offenen Zugang zum Internet, Dezentralisierung und gemeinschaftsbasierte Lösungen, sogenannte „commons-based solutions“. Ihr wichtigster Grundsatz – bekannt als der „praktische Imperativ“ – ist, dass der Zugang zu allem, was den Menschen beibringen könnte, wie die Welt funktioniert, unbegrenzt sein sollte. Es bedeutet, dass jede*r die Möglichkeit haben sollte, Computersysteme zu analysieren, zu bearbeiten und zu verbessern.

Könnte man sagen, dass Hacker*innen von Natur aus allen Systemen gegenüber skeptisch sind, weil sie wissen, dass alle Systeme missbraucht werden können?

Ja, ich denke, das ist eine sehr scharfsinnige Beobachtung.

Nochmal zurück zu den Prinzipien, von denen wir eben sprachen. Sie scheinen auf der „Hackerethik“ aufzubauen, die Steven Levy vor fast 40 Jahren beschrieben hat – ironischerweise genau im Jahr 1984.

Ja, es gibt ganze Generationen solcher Hacker*innen-Ideen, die bis in die 1950er‑Jahre zurückreichen. Levy fasste sie in den 1980er‑Jahren zusammen und sie werden auch heute noch von Hacker*innen weiterentwickelt. Heute beinhaltet die „Hacker*innen-Ethik“ die Prinzipien der Privatsphäre und Daten‑Selbstbestimmung, Transparenz, Netzneutralität, der freien Software und eben den „praktischen Imperativ“. Diese Prinzipien sind der Schlüssel, um unsere Demokratie im digitalen Zeitalter zu bewahren und Informationsdysphorie zu überwinden.

Ein Hacker*innen-Slogan, den viele Leser*innen vielleicht schon kennen, ist: „Privatsphäre für die Schwachen, Transparenz für die Mächtigen“. Warum ist Privatsphäre für die Schwachen so ein wichtiges Thema für Hacker*innen?

Privatsphäre garantiert Autonomie und Sicherheit im privaten Leben. Wenn man Nutzer*innen von Microtrageting und Fehlinformationskampagnen beschützen möchte, dann muss man ihre Privatsphäre schützen und ihnen die Kontrolle über ihre persönlichen Daten geben, sodass diese nicht missbraucht werden können. Hacker*innen arbeiten seit Jahren an zivilen Verschlüsselungstools, um Daten‑Selbstbestimmung zu ermöglichen.

Und Transparenz für die Mächtigen?

Transparenz ist das Gegenmittel gegen fehlgeleitete und korrupte Regierungen. WikiLeaks hat eine neue Zeit nie dagewesener Transparenz für die Mächtigen eingeläutet. Viele andere Leaking-Plattformen sind diesem Beispiel gefolgt, einschließlich derjenigen, die heute von den meisten Mainstream-Medienorganisationen verwendet werden.

Was ist mit den anderen Prinzipien der Hacker*innenethik?

Netzneutralität gab es im ursprünglichen Internet, das dezentralisiert war und weder die Nutzer*innen noch die Inhalte überwacht oder sie diskriminiert hätte. Jede*r konnte es frei für ihre oder seine eigenen Zwecke nutzen – es gab keine Gatekeeper. Was die Menschen verstehen müssen, ist, dass der Einsatz der Hacker*innen für Netzneutralität eigentlich ein Kampf für freie Kommunikation im digitalen Zeitalter ist.

Sie haben auch „freie Software“ erwähnt.

Freie Software bezieht sich nicht auf „frei“ im Sinne von „gratis“. Sie muss frei sein in dem Sinne, dass man sie überprüfen, modifizieren, teilen und ohne Restriktionen weiterentwickeln kann. „Black Boxen“ sollte es am besten gar keine geben. Die Idee, dass User*innen die Software kontrollieren, und nicht umgekehrt, ist ein Grundstein von Freiheit und Demokratie im digitalen Raum.

Die Idee, dass User*innen die Software kontrollieren, und nicht umgekehrt, ist ein Grundstein von Freiheit und Demokratie im digitalen Raum.

Für Ihr Buch waren Sie am vom CCC organisierten Chaos Communication Camp in Berlin und haben auch Hacker*innengruppen in Spanien und Italien besucht. Gibt es Unterschiede zwischen der europäischen Hacker*innenszene und ihrem Pendant auf der anderen Seite des Atlantiks?

Ich hatte die Ehre, Hacker*innen aus vielen verschiedenen Ländern kennenzulernen, und es gab deutliche Unterschiede zwischen den Ländern, doch speziell zwischen Europäer*innen und Amerikaner*innen – und das, obwohl es eine zunehmende Internationalisierung in der Hacker*innen-Szene gibt. Mein Eindruck war, dass die Europäer*innen – besonders die Deutschen – zugleich furchtloser und ernster sind als amerikanische Hacker*innen. Eine furchtlose, doch politisch-ernste Aktion wie die Veröffentlichung der Fingerabdrücke eines Ministers wären von einer amerikanischen Gruppe eher nicht zu erwarten. Und der Witz wäre in Amerika auch nicht so gut angekommen wie in Deutschland.

Wie unterscheidet sich die amerikanische Hacker*innenszene sonst noch?

Die amerikanische Szene ist heute stark kommerzialisiert. Viele Hacker*innen wurden vom Militär- und Sicherheitskomplex, von Big-Tech-Firmen oder sogar von der demokratischen Partei angeheuert. Hacker*innen-Konferenzen wie Defcon und Black Hat sind sehr kommerziell orientiert. 2013 hat sogar ein Mitarbeiter der US-amerikanischen Behörde für Heimatschutz die Keynote bei Defcon gehalten. Viele Leute in den USA, die sich selbst als Hacker*innen bezeichnen würden, kümmern sich nicht um die gesellschaftlichen Auswirkungen ihrer Technologie.

Hat die europäische Szene Sozial- und Demokratiebewusstsein?

In Spanien, Frankreich und Italien ist das auf jeden Fall so. Auch deutsche Hacker*innen wie der CCC haben sich immer mit der Beziehung zwischen Technologie und Gesellschaft auseinandergesetzt. Und es gibt große Fortschritte zu beobachten. So wie Nelson Mandelas Afrikanischer Nationalkongress hat sich der Ruf des CCC mit der Zeit transformiert – vom Verdacht der Kriminalität zur Seriosität. Heute sind sie eine geschätzte Gruppe, die regelmäßig vom deutschen und europäischen Parlament konsultiert wird.

Wie sieht die Zukunft der Hacker*innenbewegung aus?

Die progressive Hacker*innenszene wird zu einer wachsenden internationalen Bewegung. Sie ist immer enger vernetzt mit Bürger*innengruppen, die sich mit all den Themen auseinandersetzen, die wir heute besprochen haben. Hacker*innen versuchen auch, ihre Fähigkeiten und technologisches Verständnis einzusetzen, um die Probleme anzugehen, mit denen wir konfrontiert sind. Die demokratische Herausforderung ist jetzt, die liberalen Prinzipien des Westens zu erhalten und zugleich breiten Konsens zu erreichen. Mit Modellen der verteilten Demokratie und Entscheidungsfindung, die von einigen Hacker*innengruppen vorgeschlagen werden, könnte dies möglich sein.