Kulturtechnik Digitalität: Von der Alphanumerik zur künstlichen Intelligenz

Künstliche Intelligenz beeinflusst mit Sicherheit schon jetzt unsere traditionellen Kulturtechniken. Aber sind wir soweit, dass die Nutzung von KI selbst als eine Kulturtechnik bezeichnet werden könnte? Fest steht, dass wir im Alltag längst digitale Systeme bedienen, deren Funktionsweisen wir noch nicht mal im Ansatz verstehen.

Von Sybille Krämer

Mit Alphabet und dezimaler Zahlenschrift avancieren Schreiben, Lesen und Rechnen im aufsteigenden Handelskapitalismus Europas zu ‚Kulturtechniken‘. Erstmals ist rein schriftlich zu rechnen, ohne Abakus oder Rechenbrett. Elementare Arithmetik profanisiert sich zu einem Können, das nicht länger mathematischen Talenten vorbehalten bleibt und in der Schule lernbar ist. Wird das kleine Einsundeins, Einsminuseins, Einmaleins, Einsdurcheins auswendig beherrscht, ist das Rechnen nur noch Zeichenmanipulation auf Papier: Ein Wissen, dass es dabei um komplexe Zahlenoperationen geht, ist nicht mehr vonnöten. Um korrekt zu rechnen kann uninterpretiert bleiben, was die ‚0‘ bedeutet; wieso also ‚nichts‘ quantifiziert und als Zahl behandelt werden kann. Die Bedeutung eines Zeichens zu erkennen, heißt zu wissen, welche Zeichenoperation mit ihm auszuführen, wie ein Muster regelhaft zu transformieren ist. Das Symbolische und das Technische haben sich verbündet. Genau das ist die Essenz von Kulturtechniken. An die Stelle von Wahrheit ist Richtigkeit getreten.

Etwas zu können, ohne verstehen zu müssen, wie und warum es funktioniert, ist charakteristisch für jedweden Gebrauch technischer Apparate.

Mit dem schriftlichen Rechnen ist die symbolische Maschine formaler Zeichenoperationen geboren. Was an geistiger Arbeit formalisierbar ist, kann mechanisch-algorithmisch ausgeführt werden: ob durch Menschen oder Maschinen. Zivilisationen schreiten voran – bemerkt der Philosoph und Mathematiker Alfred North Whitehead – indem sie die Anzahl der Operationen ausweiten, die ausführbar sind, ohne über sie nachdenken zu müssen.

Der Einsatz symbolischer Maschinen formaler Zeichenoperationen ist mit Kontrolle und Transparenz verbunden: Für magische Künste und geheimnisvolle Tricks bleibt kein Platz. Sobald das Lösen von Gleichungen zur Buchstabenalgebra wird, können erstmals algebraische Regeln (beispielweise (a+b)² = a²+2ab+b²) allgemeingültig notiert werden: Aus der Algebra, vormals eine Ars Magna et Occulta, wird eine lehr- und lernbare Form der Mathematik.

Gottfried Wilhelm Leibniz (1646-1716), von Christoph Bernhard Franke

| Foto (Auschnitt): Herzog Anton Ulrich-Museum Braunschweig

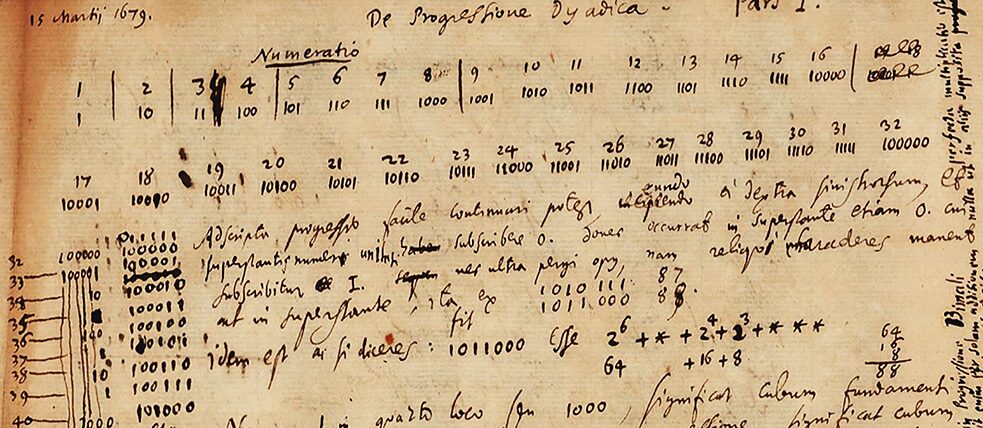

Der Kontrollraum alphanumerischer Kulturtechniken ermöglicht die Partizipation vieler an den Wissenstechniken. Diese Partizipation schließt Maschinen mit ein. Die Entwicklung von Rechenmaschinen folgte der Einführung der dezimalen Zahlenschrift auf dem Fuße. Der deutsche Philosoph Gottfried Wilhelm Leibniz (1646-1716) entwickelt die erste Vier-Spezies-Rechenmaschine. Ist es Zufall, dass er im Jahr 1703 auch das Dualzahlensystem erfindet? Sein Binäralphabet – die Rechnung mit ‚0‘ und ‚1‘ – legt jedenfalls die Grundlagen für die spätere Computerisierung. Zwar können Menschen im Dualsystem kaum rechnen, denn ihre Augen und Hände kommen mit den langen Reihen aus lediglich zwei Symbolen nicht zurecht; aber dafür können Maschinen das umso besser.

Gottfried Wilhelm Leibniz (1646-1716), von Christoph Bernhard Franke

| Foto (Auschnitt): Herzog Anton Ulrich-Museum Braunschweig

Der Kontrollraum alphanumerischer Kulturtechniken ermöglicht die Partizipation vieler an den Wissenstechniken. Diese Partizipation schließt Maschinen mit ein. Die Entwicklung von Rechenmaschinen folgte der Einführung der dezimalen Zahlenschrift auf dem Fuße. Der deutsche Philosoph Gottfried Wilhelm Leibniz (1646-1716) entwickelt die erste Vier-Spezies-Rechenmaschine. Ist es Zufall, dass er im Jahr 1703 auch das Dualzahlensystem erfindet? Sein Binäralphabet – die Rechnung mit ‚0‘ und ‚1‘ – legt jedenfalls die Grundlagen für die spätere Computerisierung. Zwar können Menschen im Dualsystem kaum rechnen, denn ihre Augen und Hände kommen mit den langen Reihen aus lediglich zwei Symbolen nicht zurecht; aber dafür können Maschinen das umso besser.

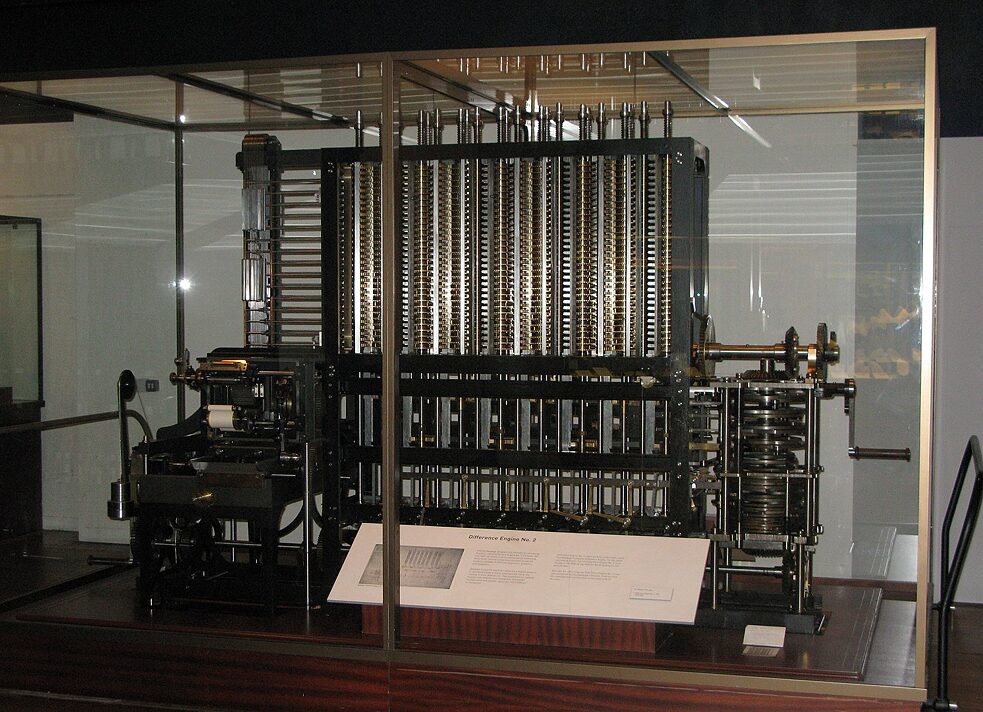

Ada Lovelace (1815-1852), die Tochter des exzentrischen Poeten Lord Byron und seiner Frau Anne Isabella Noel-Byron, erkennt 150 Jahre später die Möglichkeit, dass Maschinen nicht nur mit Zahlen, sondern – ganz im Leibniz‘schen Sinne – mit Zeichen rechnen, ob diese nun Musik, Sprache oder Zahlen repräsentieren. Sie entwickelt das erste lauffähige Programm für eine Universalmaschine, auch wenn eine solche Maschine – entworfen von Charles Babbage – bis dahin nur als Papierentwurf existierte. Ihr Programm für die automatische Berechnung der Bernoulli-Zahlen ist für Menschenhände und -augen übersichtlich in Tabellenform angeordnet.

Doch für die Maschine – so die Ideen von Lovelace und Babbage – genügt es, die binarisierten Ausgangswerte und Instruktionen als Lochkartenmuster einzugeben, welches aus der Steuerung von Webstühlen bekannt ist. Die Trennbarkeit von Hardware und Software ist damit erstmals erkannt und eingeleitet. Ada Lovelace, nicht nur mathematisch, sondern auch musisch interessiert, spricht die Hoffnung aus, solche Maschinen auch zum Komponieren von Musik einsetzen zu können.

Charles Babbages Differenzmaschine im Londoner Wissenschaftsmuseum

| Foto: User:geni, CC BY-SA 4.0

Alan Turing (1912-1954) erkennt Mitte des vergangenen Jahrhunderts, dass alles, was als Algorithmus entwickelt wird, auch von einer realen, physikalischen Maschine ausführbar ist. Mit Eingabe der Software verwandelt sich die universelle Turingmaschine in genau diejenige spezifische Maschine, deren Instruktion die Software liefert.

Charles Babbages Differenzmaschine im Londoner Wissenschaftsmuseum

| Foto: User:geni, CC BY-SA 4.0

Alan Turing (1912-1954) erkennt Mitte des vergangenen Jahrhunderts, dass alles, was als Algorithmus entwickelt wird, auch von einer realen, physikalischen Maschine ausführbar ist. Mit Eingabe der Software verwandelt sich die universelle Turingmaschine in genau diejenige spezifische Maschine, deren Instruktion die Software liefert.

Mit der Programmierbarkeit von Computern – so jedenfalls scheint es – hat der Mensch die höchste Stufe von Gestaltungsmacht und Kontrolle erreicht: alles, was in formalen Zeichenkonfigurationen beschreibbar ist, kann durch Computer ausgeführt werden. Und weil geistige Arbeit – jedenfalls zum Gutteil – so tief in der Kulturtechnik formalen Zeichenumgangs verwurzelt ist, scheint damit der Grundstein gelegt für Maschinen, die uns – sei es stückweise oder im Ganzen – das Denken abnehmen. Das Projekt künstlicher Intelligenz aus dem Geiste der Kulturtechniken formaler Symbolmanipulation nimmt Gestalt an.

Aber blendet die kulturtechnische Verankerung geistiger Arbeit nicht eine ihrer wichtigen Modalitäten aus? Der Psychologe und Nobelpreisträger Daniel Kahnemann (*1934) unterscheidet zwischen ‚langsamem‘ und ‚schnellem‘ Denken. Langsam sind die mühevollen, zeitaufwendigen, symbolverarbeitenden Kognitionen; eben jenes Denken, bei dem wir argumentieren, schreiben oder rechnen. Zweifellos sind solche Denkvollzüge kulturtechnisch konturiert. Doch wenn wir Stimmen, Gesichter oder überhaupt Objekte erkennen, dann geschieht dies zumeist mit einer Schnelligkeit, die instantan, automatisch, fast instinktiv abläuft, ohne dass wir explizit angeben könnten, was Stimme und Gesicht unseres Nachbarn von den tausend anderen Gesichtern und Stimmen unterscheidet, die wir wahrnehmen.

Sybille Krämer

| © Sybille Krämer

Sybille Krämer

| © Sybille Krämer

Tatsächlich haben seit Entstehung des Projektes ‚Künstliche Intelligenz‘ maschinelle Modellierungen dieses wahrnehmungsbasierten ‚schnellen Denkens‘ eine Rolle gespielt. Seit Warren McCulloch und Walter Pitts Neuronenmodell (1943) und Frank Rosenblatts Perzeptron (1958) gab es Versuche, auf die explizite Programmierung zu verzichten und stattdessen auf das Lernen der Maschinen zu setzen. Und dabei steht nicht die Kulturtechnik des schriftlichen Rechnens Pate, vielmehr geben Grundmechanismen vernetzter Neuronenaktivitäten das Vorbild ab. Das Aktionspotenzial einer Synapse ist die Resultante von hemmenden und verstärkenden Faktoren, welche die Gewichtung von Verbindungen verändern. Auf diese Weise – so die Grundidee – können künstliche neuronale Netze erlernen, verschiedenartige Inputs hinsichtlich eines erwünschten Outputs zu klassifizieren.

In der Konkurrenz mit dem klassischen Symbolverarbeitungsansatz zog das neuronal fundierte Maschinenlernen in allen vergangenen Hochphasen künstlicher Intelligenz zumeist den Kürzeren. Doch im ersten Jahrzehnt des 21. Jahrhunderts ändert sich die Situation: Dieser neuer Aufschwung gründet in maschinellen Lernverfahren, in Algorithmen des Deep Learning. In Gesichts- und Stimmerkennung, Übersetzungsprogrammen, Bilderkennungen aller Art oder Suchverfahrenen im Netz ist künstliche Intelligenz nicht nur auf professionellen Feldern, sondern im Alltag selbst angekommen.

Der Grund dafür sind nicht die schon seit den 1950er Jahren bekannten neuronalen Netze selbst; sondern die immensen Mengen von Trainingsdaten, die durch Webaktivitäten von Nutzern zur Verfügung stehen oder von Heeren bezahlter Clickworker produziert werden, verbunden mit der immens gesteigerten Rechenkraft der Prozessoren. So ist die Datifizierung möglich geworden, die konstante Übersetzung von Weltzuständen in einen Datenstrom. Ohne die Metamorphose der Welt in ein maschinenlesbares Datenuniversum wären Unternehmen wie ‚selbstfahrende Autos‘ hinfällig. Allerdings: Ein Kind lernt aus drei Beispielbildern zwischen Katze und Hund zu unterscheiden; beim Deep Learning mit sieben verborgenen Zwischenschichten werden dafür eine Million Beispiele benötigt. Und der Katzendetektor weiß dann immer noch nicht, dass Katzen nicht flach sind! Der extreme Datenverbrauch kann zum Limit des Deep Learning werden. Problematischer noch ist ein anderer Aspekt. Welches interne Modell der Algorithmus zur Katzenerkennung aus den Millionen seiner Trainingsdaten entwickelt hat, ist aus seinem Output nicht mehr erschließbar. Der trainierte Algorithmus verkörpert ein Knowing How, das als ein menschenverstehbares Knowing That nicht mehr zu rekonstruieren ist. Ein Blackboxing ist die Folge. Je erfolgreicher die trainierten Algorithmen arbeiten, desto unsichtbarer bleiben die dabei entwickelten internen maschinellen Modelle.

Erinnern wir uns: Menschliche Tätigkeiten zu algorithmisieren heißt explizit und intersubjektiv nachvollziehbar zu machen, wie eine Tätigkeit als Routine auszuführen ist. Doch die Veralltäglichung der Verfahren lernender KI – wie beispielweise bei den Kameraeinstellungen von Smartphones, den Staumeldungen der Navigationssysteme, oder dem Page-Ranking beantworteter Suchanfragen – führt zu einer anderen Tendenz: die Leistungseffizienz dieser Datentechnologien verschluckt die Transparenz und Verstehbarkeit von dem, wie sie dies leisten.

Ein selbstfahrendes Auto von Waymo auf der Straße in Mountain View, Kalifornien

| Foto: Grendelkhan, CC BY-SA 4.0

Die Digitalisierung impliziert eine unermessliche Steigerung unseres Zugangs zum Wissen; doch zugleich wachsen die Regionen eines intransparenten, verborgenen Knowing-Hows gerade in Verbindung mit den avanciertesten Wissenstechniken. Lohnt es an dieser Stelle daran zu erinnern, dass auch die Demokratisierung des Wissenszugangs durch die Kulturtechnik des schriftlichen Rechnens verbunden war mit dem Verzicht auf ein Verständnis, warum diese Rechenregeln überhaupt funktionieren, was die Null bedeutet oder warum eine Zahl nicht länger als eine abzählbare ‚Anzahl‘ gilt?

Ein selbstfahrendes Auto von Waymo auf der Straße in Mountain View, Kalifornien

| Foto: Grendelkhan, CC BY-SA 4.0

Die Digitalisierung impliziert eine unermessliche Steigerung unseres Zugangs zum Wissen; doch zugleich wachsen die Regionen eines intransparenten, verborgenen Knowing-Hows gerade in Verbindung mit den avanciertesten Wissenstechniken. Lohnt es an dieser Stelle daran zu erinnern, dass auch die Demokratisierung des Wissenszugangs durch die Kulturtechnik des schriftlichen Rechnens verbunden war mit dem Verzicht auf ein Verständnis, warum diese Rechenregeln überhaupt funktionieren, was die Null bedeutet oder warum eine Zahl nicht länger als eine abzählbare ‚Anzahl‘ gilt?

Die Janusköpfigkeit der Technologie besteht nicht nur darin, dass sie guten wie schlechten Zwecken dienen kann. Sie bedeutet auch, dass Wissen und Nichtwissen im Technikgebrauch zwei Seiten derselben Medaille bilden. Denn ein Gerät gebrauchen zu können und zu wissen wie es funktioniert – diese Dinge sind für Techniknutzer nicht dasselbe. Und dieses Spannungsverhältnis mag modifizierbar sein, aber vollends aufgehoben werden kann es nicht.

Wenn wir künstliche Intelligenz als eine Kulturtechnik 4.0 bezeichnen, dann stellt sich die Frage, ob wir sie als eine ‚gewöhnliche Technik‘ innerhalb dieses Spannungsverhältnis von Wissen/Nichtwissen ansehen sollten. Fest steht: Selbst wenn wir sie so einordnen, dann müssen dennoch mit umstürzenden Folgen für Kultur und Gesellschaft rechnen, ähnlich wie es dereinst mit der Dampfmaschine zu Beginn der industriellen Revolution geschehen ist.

Dieser Artikel ist ein Teil von Kulturtechniken 4.0, einem Webprojekt des Goethe-Instituts in Australien, das sich mit dem Zusammenspiel von künstlicher Intelligenz und traditionellen Kulturtechniken befasst.