Künstliche Intelligenz und Falschmeldungen

Wenn Roboter verzerrte Inhalte in den sozialen Medien erzeugen

Facebook, Twitter, LinkedIn: In jedem sozialen Netzwerk können automatisierte Systeme Desinformationen erzeugen und verbreiten. | Foto (Detail): © colourbox.com

Weltweit setzen Organisationen Systeme Künstlicher Intelligenz (KI) in großem Umfang ein. Jedoch werden diese Systeme nicht immer vorteilhaft genutzt und treffen auch nicht immer die besten Entscheidungen. In diesem Artikel behandle ich anhand von drei Beispielen drei Typen Roboter, die voreingenommene Inhalte erzeugen können: Social Bots, die Desinformation verbreiten, verzerrende KI‑Tools und synthetische Profile.

Von Brian L. Due

Drei Typen, die man beachten sollte

In diesem Artikel werden unter Künstlicher Intelligenz (KI) automatisierte Software‑Roboter verstanden, die auf fortschrittlichen Algorithmen basieren und von Menschen programmiert wurden. Diese Systeme wurden mit umfangreichen, aber spezifischen Datensätzen gezielt trainiert. KI kann Inhalte erzeugen, die erfunden und verzerrt sind, und für gewöhnlich lassen sich die Quellen dieser Inhalte nicht ermitteln. Nutzer*innen, die dies nicht erkennen können, verbreiten diese Inhalte gezielt, ohne zu wissen, dass sie falsch sind. Dies nennen wir Desinformation, weil sie gezielt in die Irre führt oder manipuliert.Wohin das führt, lässt sich beispielsweise an der rassistisch motivierten Falschinformation zeigen, die 2016 während des Brexit‑Referendums in den sozialen Medien zirkulierte: In sogenannten dark Ads, dunklen Anzeigen, die an Facebook‑Nutzer*innen gerichtet waren, wurde die Falschmeldung verbreitet, dass die Europäische Union 76 Millionen Türken*innen visafreie Einreise gewähren würde.

Gemeinsam war den Nutzer*innen dieser Gruppe ihre Angst vor zunehmender Immigration und Verlust der Souveränität. Aufgrund dieser Gemeinsamkeiten wurden sie von Algorithmen herausgefiltert. Solche Kampagnen zielten darauf ab, Brexit‑Befürworter*innen an die Wahlurnen zu bringen, sie untergraben jedoch das Prinzip demokratischer Entscheidungsfindung.

Auch wenn falsche KI‑erzeugte Inhalte „nur so“ und ohne böse Absicht verbreitet werden, können sie zu Verzerrungen oder Falschinformationen führen. Hier gehen wir auf drei Phänomene genauer ein, denen folgende Kennzeichen gemeinsam sind:

a) die Generierung von KI‑Inhalten, die

b) eine Form von Lüge sind und

c) ein Vorurteil bestätigen oder eine Verzerrung bewirken.

Unter Content (Inhalt) wird hier Information verstanden, die einem breiten Publikum zugänglich ist. Fake (Fälschung) bedeutet, dass die Information irreführend ist, weil es sich um falsche oder Desinformation handelt. Als Bias (Vorurteil, Voreingenommenheit, Verzerrung) im weitesten Sinne des Wortes wird die unverhältnismäßig starke Beeinflussung definiert, die – oft unbeabsichtigt und unbewusst – für oder gegen einen Sachverhalt oder Personen stattfindet.

Im Folgenden beschreibe ich drei Typen Software‑Roboter, wobei ich auf diese Punkte genauer eingehe:

1. den Unterschied zwischen Desinformation/falscher Information,

2. den Zusammenhang zwischen Inhalt, Lüge und Vorurteil und

3. ihr Auftreten in verschiedenen sozialen Plattformen.

Es gibt auch andere Möglichkeiten, diese Typen darzustellen. Einer der Aspekte, die nicht behandelt werden, ist die zunehmende Anwendung von Deepfakes.

1. Social Bots, die desinformieren: Wenn Lügenroboter‑Profile Desinformation verbreiten

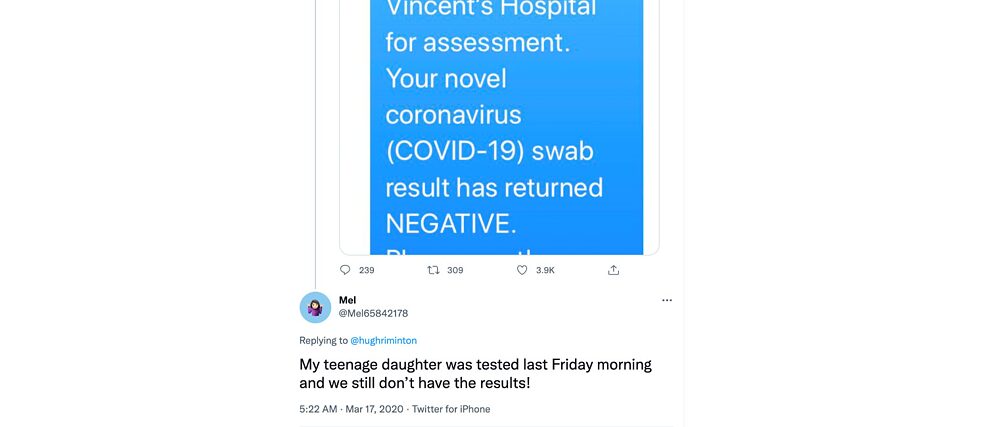

Der erste Typ eines Lügenroboters ist vielfach auf den großen Plattformen wie Facebook und Twitter zu finden. Hier stoßen wir auf KI‑Profile, die zunächst von Menschen zu sein scheinen. Sie verbreiten Desinformation über aktuelle Themen, vor allem auf dem Gebiet der Politik. Sieht man sich diese Profile genauer an, entdeckt man, dass sie numerische Namen haben und im Netzwerk ziemlich neu sind, keine oder nur sehr wenige Follower haben und engstirnige und einseitige Posts schreiben. Es gibt viele Beispiele für die Armee der Roboter, die politische Prozesse unterminieren. Hier spricht man von der „Bewaffnung der sozialen Medien“ (weaponization of social media). Neuere Beispiele beziehen sich auf Covid‑19, in denen Bots Falschinformation verbreiten, die das Misstrauen gegen die Regierung schüren (siehe Beispiel 1).Beispiel 1: Ein falsches Social-Media-Konto von Bot „Mel65842178“. Es handelt sich um einen automatisch generierten Bot, der Kommentare in die Social‑Media‑Feeds postet, mit denen er Desinformation oder die Beeinflussung der öffentlichen Meinung beabsichtigt. In diesem Fall verbreitet Mel schon allein dadurch Fake News, dass der Roboter keine Tochter haben kann und die beschriebenen Vorfälle nicht stattgefunden haben können. Zudem retweetet er einseitigen hasserfüllten Kommentar.

2. Verzerrende KI-Tools: Wenn mit KI erzeugter Inhalt zu Falschinformation führt

Der zweite Typ voreingenommener Roboter sind KI‑Algorithmen, die in bestimmten Plattformen als Tools vorhanden sind. Diese Algorithmen sollen ein effizienteres Arbeiten ermöglichen, beispielsweise indem sie Nutzer*innen ein Wort oder eine Abbildung vorschlagen oder Sätze vervollständigen. Diese KI‑Tools basieren nicht nur auf prädiktiven, also vorhersagebasierten, sondern auch auf prädiktiven, vorschreibenden Analysen und veranlassen die Nutzer*innen, sofort eine Aktion zu unternehmen, weil die folgenden Handlungen bereits im Tool eingebettet sind. Dabei kann unbewusste Verzerrung stattfinden, beispielsweise weil diese Tools von einer bestimmten Gruppe Entwickler (zum Beispiel weißen Männern) generiert und mit voreingenommenen Daten gefüttert wurden. Zu den frühen Beispielen zählen Polizei‑Algorithmen (für die prädiktive Polizeiarbeit), die dazu führen, dass die Polizei sich auf Wohnviertel mit einem hohen Anteil an ethnischen Minderheiten konzentriert, ungeachtet der tatsächlichen Kriminalitätsrate in diesem Gebiet. Ein neueres Beispiel ist das Bildzuschnitt‑Tool von Twitter: Postet man lange und schlanke Fotos, konzentriert sich das Tool auf den Teil des Tweets, den es für den besten hält. Es schneidet Abbildungen so zu, dass Leute mit weißer Hautfarbe denen mit Schwarzer Hautfarbe vorgezogen werden (siehe Beispiel 2). Beispiel 2: Das Bildzuschnitt-Tool von Twitter konzentriert sich eher auf weiße Gesichter als auf Schwarze. Das Originalbild ist das linke mit 11 Personen mit Schwarzer und einer Person mit weißer Hautfarbe. Der Zuschnittsalgorithmus hat sich auf den einzigen weißen Mann konzentriert. Es soll nicht unerwähnt bleiben, dass Twitter das Problem schnell in den Griff bekam.3. Synthetische Profile: Wenn erfundene Profile zu Desinformation führen

Der dritte Typ Roboter sind synthetische „Menschen“, nämlich Roboter, die man Humanoide nennen würde, wenn sie physisch auftreten würden. Als Software-Roboter haben sie ein Profil entwickelt, das etwas überzeugender ist als das der Social Bots, die scharenweise ohne Hintergrundgeschichte auftreten. Synthetische Profile sind auf Instagram als Influencer sehr berühmt. Das Paradebeispiel ist #lilmiquela. Rund um Fake-Personen mit Gesichtern und Inhalt, die von einer KI geschaffen wurden, ist eine ganze Industrie entstanden. Sehen Sie sich auf ThisPersonDoesNotExist.com die erfundenen Gesichter an. Mit ihnen kann man verzerrten Inhalt erzeugen und Desinformation verbreiten. Ein Schlüsselbeispiel findet man auf LinkedIn, wo das Profil „Katie Jones“ mit prominenten Profilen aus der amerikanischen Politik netzwerken konnte (siehe Beispiel 3). Beispiel 3: Das LinkedIn-Profil „Katie Jones“ gibt es nicht. Es ist ein Fake, ein synthetisches KI‑konstruiertes Gesicht. Associated Press hat das Profilbild analysiert und festgestellt, dass es ein typisches Beispiel für Spionagetätigkeiten auf der Site des professionellen Netzwerks ist.Fake News entlarven

In den sozialen Medien findet man verschiedene Profile und Typen von KI‑erzeugten Inhalten. In diesem Artikel habe ich drei Typen vorgestellt: Social Bots, die desinformieren, verzerrende AI‑Tools und synthetische Profile. Zweifelsohne können Roboter sehr hilfreich sein, wenn Information, die wahr und als KI‑generiert gekennzeichnet ist, verbreitet werden soll. Zudem könnten Roboter auch dazu eingesetzt werden, um verzerrte Informationen im Allgemeinen zu bekämpfen. Das Western Norway Research Institute beispielsweise versucht, Fake News und Hasskommentare mit KI zu entlarven.Kein Mensch ist frei von Vorurteilen. Daher ist es auch nicht möglich, ein KI‑System zu erstellen, das frei von Vorurteilen ist. Aber wir können sicherlich Vieles besser machen als jetzt.