Künstliche Intelligenz gegen Hass im Netz

Moderne Technik mit vielen Fragezeichen

In fünf bis zehn Jahren könnten künstlichen Intelligenzen „Hate Speech“ auch in ihren Nuancen erkennen und automatisch löschen, sagte Mark Zuckerberg in seiner Anhörung vor dem US-Kongress. Doch bereits heute zeigen Forschungsprojekte die Chancen dieser Technologie – und über welche Punkte schon bald diskutiert werden muss.

„Eine neue Form der KI entdeckt 90 Prozent aller Onlinebeschimpfungen“, titelte 2016 das US-amerikanische Magazin Fortune. Gemeint war ein von Yahoo entwickelter Algorithmus, der auf Grundlage von einer Million Kommentaren des Portals trainiert wurde. Das Programm steche durch seine Genauigkeit die Konkurrenten aus. Die Forscher wollten damals über die reine Stichwortanalyse von Nutzerbeiträgen hinausgehen und speisten deshalb die Daten der Kommentarspalten von Yahoo News und Finanzen in den Algorithmus ein. Das Problem der Hasskommentare ist seitdem nicht gelöst worden. Im April 2018 erwähnte Mark Zuckerberg in seiner Anhörung vor dem US-Kongress, dass künstliche Intelligenzen in zehn Jahren Hate Speech bei Facebook auch in sprachlichen Nuancen erkennen und automatisch löschen könnten.

Doch wie schlau ist die Technologie bereits heute? Welche Probleme ergeben sich bei der Nutzung? Und wo liegen die Schwachpunkte?

Zuckerbergs Aussage vor dem Kongress hat die Medienlinguistin Sylvia Jaki von der Universität Hildesheim und ihren Forscherkollegen, Sprachtechnologe Tom De Smedt, überrascht: „Wir haben beide gestutzt, denn gerade im englischsprachigen Raum sind die Forscher bereits sehr weit“, so Jaki. Fünf bis zehn Jahre werde es sicher nicht mehr dauern, denn eigentlich seien moderne Maschinen schon heute in der Lage dazu. „Zuckerberg wirkte uninformiert, aber womöglich hat er auch eine andere Vision und möchte eine fast 100-prozentige Genauigkeit.“

Wo hört die Meinungsfreiheit auf?

Gemeinsam mit Wissenschaftlern der Universität Antwerpen hat Jaki den Hate-Speech-Detektor für Twitter realisiert. Dieses automatisierte Programm spürt in Echtzeit hetzerische Wörter und Wortkombinationen in deutschsprachigen Tweets auf und bezieht auch Elemente wie Bilder und Emojis mit ein. Auf mittlerweile 84 Prozent Treffergenauigkeit komme der Algorithmus, sagt die dafür mitverantwortliche Medienlinguistin. Dass es die perfekt fahndende Maschine auf absehbare Zeit geben wird, glaubt Jaki nicht. „Es wird wohl immer eine menschliche Nachkorrektur nötig sein.“„Die Maschinen lesen auf den Zeilen, Menschen lesen zwischen den Zeilen“, sagt Aljoscha Burchardt, Forscher am Language Technology Lab vom Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI), und verweist auf die Mehrdeutigkeit der Sprache. Für die Erkennung simpler Sprachmerkmale seien maschinelles Lernen und Algorithmen nützlich. Da gleichen sie einem Filter im Spamordner. „Die Grenzen der Technologie sind jedoch bei Anspielungen, Ironie und beim kulturellen Kontext erreicht. Subtile Aussagen, bei denen sozusagen zwischen den Zeilen steht, was gemeint ist und das jeder Mensch versteht, sind für Algorithmen kaum zu erkennen.“ Deshalb stehle sich Zuckerberg mit seinem Verweis auf künstliche Intelligenzen aus der redaktionellen Verantwortung, so Burchardt. Er betont: „In dem Bereich der Identifizierung von Hassrede müssen menschliche Experten arbeiten.“

Die Kernfrage in der Diskussion: Wie gehen Gesellschaften mit künstlicher Intelligenz bei der Bekämpfung von Hasskommentaren um? „Zensur ist das Stichwort, das häufig genannt wird“, sagt Sylvia Jaki. „Das eine Lager ist von solchen Möglichkeiten begeistert und das andere sagt, dass diese gegen die Meinungsfreiheit verstoßen.“ Außerdem wird es maßgeblich sein, wie einzelne Organisationen und Behörden den Begriff „Hate Speech“ definieren. „Zuckerberg kam bei der Anhörung ins Straucheln und sprach von Aufruf zu Gewalt, mehr nicht“, sagt Jaki. Dass Facebook seine eigenen Standards inkonsequent umsetzt, zeigen zwei Fälle, bei denen die US-Firma Facebook insbesondere über die Verbreitung von Desinformation und Propaganda zu Morden aus Hass beigetragen hat. Dazu gehören der Fall der Rohingya in Burma und der Bürgerkrieg in Sri Lanka. Eine Buzzfeed-Recherche hat gezeigt, dass Facebook trotz zahlreicher Warnungen von Politikern und Forschern über Jahre kaum reagiert hat.

Auch auf institutioneller Ebene gibt es keine einheitliche Auffassung. „Die EU verfügt über keine rechtsgültige Definition, was unter Hassrede konkret zu verstehen ist.“ Üble Nachrede und andere strafrechtlich relevante Fälle gehören zweifelsfrei dazu, betont Jaki. „Aber wann ist freie Meinungsäußerung keine mehr?“. Jakis Beispiel: Im Graubereich befinden sich Kommentare, in denen Migranten als Kriminelle dargestellt werden. Diese sind von der Meinungsfreiheit gedeckt. „Die Häufigkeit der Tweets macht daraus jedoch ‚Hate Speech‘, weil es durch die gezielte Herabsetzung zu politischer Propaganda wird.“

DFKI-Forscher Burchardt erklärt den Mechanismus: „Es gibt zwei Wege, wie man Maschinen aufschlauen kann. Erstens per Algorithmus oder zweitens man lässt sie mit einem Datensatz lernen.“ Je größer und besser die Informationen darin, desto genauer wird die Maschine. Er schränkt jedoch ein: „Was der Mensch nicht gut kann, kann die Maschine erst recht nicht.“ Heißt: Wenn sich Menschen nicht einigen können, welche Aussagen in den Grenzen der Meinungsfreiheit liegen und welche nicht, wird es schwierig, es einer Maschine beizubringen, die das Urteil dann übernimmt.

Das Problem mit dem Sarkasmus

Digitalexperte Sascha Lobo hat in seiner Kolumne auf Spiegeln Online geschrieben, dass es derzeit noch unklar sei, wie das Zusammenspiel zwischen Staaten und Unternehmen aussehen wird. Ein einzelnes „Lex Facebook“ sei wenig sinnvoll. „Viel eher müssten für eine kluge Regulierung vom Konzept Datenschutz über Mediengesetzgebung bis zu einer Reihe von Grundrechten (etwa zu Zensur und Meinungsfreiheit) umfangreiche Updates erarbeitet werden“, konstatiert Lobo.„Die Kommentare zu löschen, ist die simple Lösung“, sagt Burchardt. Für ihn ist das nicht konstruktiv. „Gerade bei Kommentaren im besagten Graubereich, bei denen es keine juristische Handhabe gibt, hilft das Löschen nicht.“ Statt den Kommentar zu entfernen, könne man auch versuchen, einen Diskurs mit dem Verfasser aufzubauen und mit ihm ins Gespräch zu kommen, so der Wissenschaftler. „Spätestens bei diesem Schritt sind Menschen gefragt. Da kann die Maschine im Vorfeld lediglich filtern und sortieren.“

Die Ursache von Hasskommentaren sei auch durch künstliche Intelligenzen kaum lösbar, glaubt indes die Medienlinguistin Jaki: „Mit der Lösung des Symptoms kann man aber schon viel bewirken. Durch die Hasskommentare einer Minderheit wird der Eindruck erweckt, dass die Gesellschaft geteilt sei. Die Verringerung der Sichtbarkeit kann da sicherlich entgegenwirken.“ Eine der spannendsten Fragen, betonen die Wissenschaftler, sei folgende: „Wie geht man mit Sarkasmus um?“ Denn es handele sich bei Aussagen aus dieser Kategorie selbstverständlich nicht um Hasskommentare, aber sie erfüllten häufig die Kriterien dafür.

„Kommentare zu löschen ist die simple Lösung“

Forscher des MIT in Cambridge haben sich diesem Problem gewidmet, wobei sie zunächst ein System erschaffen wollten, das rassistische Beiträge auf Twitter erkennt. Dann fiel dem Team auf, dass sich viele Aussagen ohne die Beachtung von Sarkasmus nicht kategorisieren lassen. Der auf „Deep Learning“ basierende Algorithmus namens DeepMoji trainierte mit 1,2 Milliarden Tweets, die zudem eine Kombination aus 64 Emojis beinhaltete. Im Test schnitt er besser ab als Menschen. Während die menschlichen Prüfer in 76 Prozent der Fälle richtig lagen, erreichte DeepMoji einen Wert von 82 Prozent.Der US-Konzern Alphabet und dessen Tochter Google arbeiten ebenfalls seit geraumer Zeit an einem Algorithmus, der bösartige und beleidigende Aussagen erkennen und Unterhaltungen im Netz verbessern soll. Deren Projekt trägt den Namen „Perspective“ und wurde von der Forscherinitiative „Conversation AI“ programmiert. Dabei handelt es sich um einen Algorithmus, der Hasskommentare selbständig erkennt und darüber hinaus fortwährend dazu lernt. Die sogenannte API (Programmierschnittstelle) erkennt mit Hilfe von Techniken des maschinellen Lernens verschiedene Arten von Beleidigungen. Auf der Website heißt es dazu: „Wir möchten herausfinden, wie Computer lernen können, die Nuancen und den Kontext solcher Äußerungen in größerem Maßstab zu verstehen. Maschinelles Lernen könnte dann Verlagen, Webpublishern und Moderatoren helfen, Kommentare auf ihren Plattformen besser zu verwalten, und so den Ideenaustausch im Internet fördern.“ Kooperationen bestehen mit der New York Times, The Guardian, The Economist und Wikipedia.

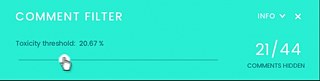

Der Kommentar-Filter ist eine andere digitale Erweiterung, die auf dem Algorithmus „Perspective“ basiert. Dabei können Leser selbstständig auswählen, wie viele vermeintliche Hasskommentare sie sehen möchten. Je nachdem wie stark der Filter eingestellt ist, werden die Kommentare für den Nutzer mehr oder weniger verborgen. Die Tools sind bislang lediglich für den englischsprachigen Raum verfügbar.

Text: meedia.de, Thomas Borgböhmer

13.04.2018