Umělá inteligence proti nenávisti na internetu

Moderní technika s řadou otazníků

Za pět až deset let by umělá inteligence mohla být schopná rozpoznat „hate speech“ i co do jemných nuancí a příslušné příspěvky automaticky vymazat, řekl Mark Zuckerberg během slyšení před americkým Kongresem. Výzkumné projekty však již dnes ukazují možnosti této technologie – a také to, o jakých tématech budeme již brzy muset diskutovat.

V roce 2016 přinesl americký magazín Fortune titulek „Nová forma umělé inteligence rozpozná 90 procent všech urážek na internetu“. Myšlen byl algoritmus vyvinutý společností Yahoo na základě milionu komentářů obsažených na portále. Nad konkurencí prý program vítězí svou přesností. Vědci chtěli tehdy jít nad rámec prosté analýzy hesel v příspěvcích uživatelů a vložili proto do algoritmu data z komentářů na stránkách Yahoo News a Finanzen. Problém nenávistných komentářů se od té doby vyřešit nepodařilo. V dubnu 2018 zmínil Mark Zuckerberg ve slyšení před americkým Kongresem, že umělá inteligence bude během deseti let schopna detekovat hate speech na Facebooku i co do jazykových nuancí a příslušné příspěvky automaticky vymazat.

Nakolik inteligentní je však tato technologie již dnes? Jaké problémy se objevují při jejím užívání? A kde jsou její slabá místa?

Zuckerbergův výrok před Kongresem překvapil lingvistku Sylvii Jaki z Univerzity v Hildesheimu, která se specializuje na problematiku médií, a jejího kolegu, vědce a jazykového technologa Toma De Smedta: „Oba nás to zarazilo, neboť vědci v anglickém jazykovém prostoru již dosáhli velkého pokroku“, uvedla Jaki. Pět až deset let to už určitě trvat nebude, neboť moderní technika je toho vlastně schopna již dnes. „Vypadalo to, jako by Zuckerberg nebyl dostatečně informován, ale možná měl jen odlišnou představu a chtěl by dosáhnout takřka stoprocentní přesnosti.“

Kde končí svoboda projevu?

Spolu s vědci z Univerzity v Antverpách vyvinula Sylvia Jaki pro Twitter detektor nenávistných příspěvků. Tento automatizovaný program je schopen vypátrat v reálném čase štvavé výrazy a slovní spojení v německojazyčných tweetech a zohlednit přitom i prvky, jako jsou obrázky a emodži. V současnosti dosahuje algoritmus při vyhledávání přesnosti 84 procent, říká lingvistka, která k tomuto výsledku přispěla svým dílem. Tomu, že se v dohledné době podaří vytvořit stroj schopný dokonalé detekce, Jaki nevěří. „Dodatečné korektuře ze strany člověka se zřejmě nevyhneme nikdy.“„Stroje čtou na řádcích, lidé mezi řádky“, říká vědec Aljoscha Burchardt z Language Technology Lab při Německém centru pro výzkum umělé inteligence (DFKI) a poukazuje na mnohoznačnost jazyka. Pro identifikaci jednoduchých jazykových charakteristik jsou algoritmy a strojové učení užitečné. V tomto ohledu fungují stejně jako spamový filtr. „Hranic však technologie dosahuje v případě narážek, ironie a kulturního kontextu. Rafinované výroky, jejichž obsah se takříkajíc skrývá mezi řádky a je srozumitelný každému člověku, algoritmy takřka nejsou schopné rozeznat.“ Proto se Zuckerberg odkazem na umělou inteligenci snaží zbavit redakční odpovědnosti, říká Burchardt a zdůrazňuje: „V oblasti identifikace nenávistných příspěvků musí pracovat patřičně vyškolení lidé.“

Klíčovou otázkou objevující se v diskusi je, jak společnosti využívají umělou inteligenci v boji proti nenávistným komentářům. „Často zaznívá heslo cenzura“, říká Sylvia Jaki. „Jeden tábor je takovýmito možnostmi nadšen, podle druhého jde o porušování svobody projevu.“ Zásadní roli bude kromě toho hrát, s jakou definicí hate speech přijdou jednotlivé organizace a úřady. „Zuckerberg během slyšení působil rozpačitě a mluvil o vyzývání k násilí, ničem dalším“, říká Jaki. Že své vlastní standardy uvádí Facebook do praxe nedůsledně, dokládají dva případy, v nichž tato americká firma přispěla zejména prostřednictvím šíření dezinformací a propagandy k vraždění motivovanému nenávistí. Patří k nim případ Rohingů v Burmě a občanská válka na Srí Lance. Rešerše společnosti Buzzfeed ukázaly, že Facebook navzdory mnoha varováním ze strany politiků a vědců řadu let takřka nereagoval.

Screenshot: perspectiveapi.com

Screenshot: perspectiveapi.com

Rovněž na institucionální úrovni nepanuje shoda. „Evropská unie nemá právoplatnou definici toho, co přesně označit jako nenávistný výrok.“ Pomluva a jiné případy z trestněprávní oblasti do této kategorie nepochybně patří, zdůrazňuje Jaki. „Kdy se však svoboda projevu mění ve svůj opak?“. Sylvia Jaki uvádí příklad: V šedé zóně se nacházejí komentáře, v nichž jsou migranti líčeni jako zločinci. Na tyto příspěvky se svoboda projevu vztahuje. „Četnost tweetů z nich však dělá hate speech, neboť se cíleným hanobením mění v politickou propagandu.“

Burchardt, vědecký pracovník DFKI, vysvětluje příslušný mechanismus: „Existují dva způsoby, jak zvýšit inteligenci strojů. Buď prostřednictvím algoritmu, nebo tak, že je necháme se učit ze souboru dat.“ Čím rozsáhlejší a kvalitnější informace v nich obsažené budou, tím vyšší přesnosti bude stroj dosahovat. Uvádí však omezení: „Co dobře nezvládá člověk, nebude stroj umět tím spíše.“ V praxi to znamená, že pokud se lidé nejsou schopni shodnout na tom, které výroky se pohybují v hranicích svobody projevu a které nikoliv, bude obtížné to naučit stroj, který pak převezme roli soudce.

Problém se sarkasmem

Odborník na digitální technologie Sascha Lobo napsal ve svém sloupku na stránkách Spiegel Online, že v současnosti není stále jasné, jakou podobu bude mít interakce mezi státy a firmami. Speciální „lex Facebook” nemá valného smyslu. „Aby byla možná inteligentní regulace, bylo by spíše nutné připravit rozsáhlé aktualizace – koncepcí ochrany údajů počínaje přes legislativu v oblasti médií až po řadu základních práv (např. týkajících se cenzury a svobody projevu)“, konstatuje Lobo.„Smazat komentáře je to nejsnazší řešení“, říká Burchardt. V jeho očích nikoliv konstruktivní. „Právě v případě komentářů ve zmiňované šedé zóně, kde k tomu není právní důvod, mazání nepomůže.“ Namísto abychom komentář odstranili, bychom se také mohli pokusit o spojení a komunikaci s jeho autorem, říká vědec. „Nejpozději v této fázi jsou potřeba lidé. Tady může stroj příspěvky jen předběžně profiltrovat a vytřídit.“

Lingvistka Sylvia Jaki je nicméně přesvědčená, že příčinu nenávistných komentářů lze s pomocí umělé inteligence odstranit jen stěží: „Avšak již samotnou eliminací symptomu toho můžeme hodně dosáhnout. Nenávistné komentáře menšiny vzbuzují dojem, že je společnost rozdělená. Snížení jejich viditelnosti může nepochybně působit jako protiopatření.“ Jedna z nejzajímavějších otázek, zdůrazňují vědci, je, jak přistupovat k sarkasmu. Neboť v případě výroků z této kategorie nejde samozřejmě o nenávistné komentáře, ačkoliv nezřídka kritéria pro ně daná splňují.

„Smazat komentáře je to nejsnazší řešení“

Vědci z MIT v Cambridgi se tímto problémem zabývali, přičemž chtěli nejdříve vytvořit systém, který by na twitteru detekoval rasistické příspěvky. Pak si členové týmu povšimli, že řadu výroků nebylo možné kategorizovat, aniž by vzali v potaz sarkasmus. Algoritmus s názvem DeepMoji založený na „Deep Learning“ vycvičili na 1,2 miliardách tweetů, které mimoto obsahovaly kombinaci ze 64 emodži. V testu dosahoval lepších výsledků než lidé. Zatímco kontroly provedené lidmi byly úspěšné v 76 procentech případů, dosáhl DeepMoji skoré 82 procent.Americký koncern Alphabet a jeho dceřiná společnost Google pracují rovněž již delší dobu na algoritmu, který by byl schopen rozpoznat zlé a urážlivé výroky a zlepšit komunikaci na webu. Jejich projekt se jmenuje „Perspective“ a program k němu vyvinula iniciativa vědců „Conversation AI“. Jde přitom o algoritmus, který detekuje nenávistné komentáře bez další podpory a kromě toho neustále rozšiřuje své znalosti. Tzv. API (programovací rozhraní) rozezná s pomocí techniky strojového učení různé typy urážek. Na webových stránkách k tomuto tématu stojí: „Chtěli bychom zjistit, jak se počítače mohou naučit porozumět nuancím a kontextu takovýchto vyjádření ve větším měřítku. Strojové učení by pak mohlo pomoci nakladatelstvím, internetovým vydavatelům a moderátorům lépe spravovat komentáře na jejich platformách a přispívat tak k výměně názorů na internetu.“ Již dnes koncern spolupracuje s New York Times, The Guardian, The Economist a s internetovou encyklopedií Wikipedia.

Screenshot: github.com

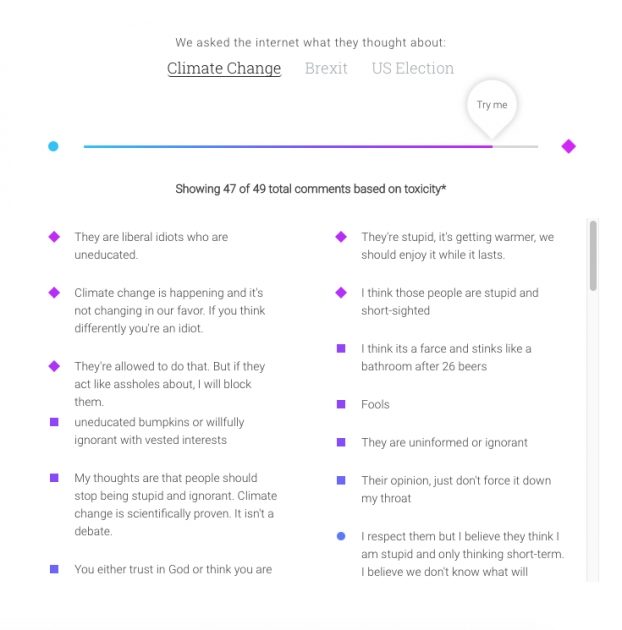

Rozhraní slouží k tomu, aby různým vědcům poskytlo algoritmus pro vývoj jejich nástrojů proti nenávistným komentářům. První projekt z této řady představoval začátkem roku 2017 posuvný regulátor zařazující komentáře z různých diskusí na škále od 1 (velmi konstruktivní) až po 100 (hate speech). Nástroj přitom analyzoval nejrůznější výroky týkající se témat změna klimatu, brexit a volby ve Spojených státech. Věty se pokouší zkoumat komplexně a nikoliv pouze vyhledávat „toxický obsah“ podle hesel.

Screenshot: github.com

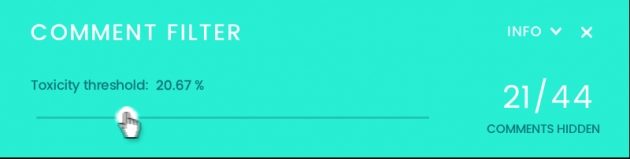

Rozhraní slouží k tomu, aby různým vědcům poskytlo algoritmus pro vývoj jejich nástrojů proti nenávistným komentářům. První projekt z této řady představoval začátkem roku 2017 posuvný regulátor zařazující komentáře z různých diskusí na škále od 1 (velmi konstruktivní) až po 100 (hate speech). Nástroj přitom analyzoval nejrůznější výroky týkající se témat změna klimatu, brexit a volby ve Spojených státech. Věty se pokouší zkoumat komplexně a nikoliv pouze vyhledávat „toxický obsah“ podle hesel. Filtr komentářů je dalším elektronickým doplňkem vycházejícím z algoritmu „Perspective“. Čtenáři si přitom sami mohou zvolit, kolik potenciálně nenávistných komentářů chtějí vidět. Podle toho, nakolik citlivě je filtr nastaven, se uživateli bude zobrazovat větší či menší množství komentářů. Tyto nástroje jsou v současnosti k dispozici pouze pro anglický jazykový prostor.

Text: meedia.de, Thomas Borgböhmer

13.04.2018